Чтобы сохранить большие данные от утечек, чиновники придумывают различные законы, а разработчики чинят уязвимости в Big Data системах. Продолжая разговор про информационную безопасность больших данных, сегодня мы подготовили для вас статью про технические средства защиты кластера Apache Hadoop.

Возможные угрозы для кластера Big Data и средства их предотвращения

В реальности экосистема больших данных существует не в информационном вакууме, а в корпоративной ИТ-инфраструктуре, в рамках которой администратор Big Data должен обеспечить безопасное и эффективное использование кластера. С этой позиции можно выделить следующие направления защиты кластера Apache Hadoop:

- предотвращение атак и несанкционированного доступа к Big Data извне – организация защищенного периметра;

- безопасное использование больших данных внутренними клиентами (пользователями и корпоративными информационными системами) – обеспечение эффективной и безопасной интеграции;

- комплексный мониторинг и администрирование всех задач, связанных с безопасностью Big Data.

Как правило, в состав готовых дистрибутивов Hadoop (Cloudera, HortonWorks, ArenaData, MApR и др., а также облачных решений HDInsight, Amazon EMR, MCS и т.д.) включены дополнительные инструменты реализации корпоративных моделей безопасности: инструменты поддержки политики доступа на основе атрибутов или ролей (RBAC), обеспечения защищенного периметра, системы мониторинга, защищенные протоколы передачи данных, средства шифрования и изоляции. Некоторые из них относятся к проприетарным решениям вендоров, в частности, Cloudera Navigator Encrypt, MapR Native Security или интеграция HDInsight от Microsoft Azure с Active Directory. Другие являются общедоступными инструментами (например, защищенный сетевой протокол аутентификации Kerberos) или основаны на проектах Apache Software Foundation: Knox, Atlas, Ranger. Именно их мы рассмотрим подробнее в настоящей статье.

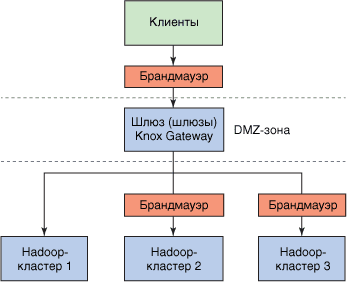

Защита периметра с помощью шлюза Apache Knox Gateway

Apache Knox Gateway реализует внешний уровень защиты кластера Hadoop, обеспечивая безопасность по периметру кластера. Это решение позволяет детально контролировать доступ к данным и сервисам платформы Hadoop, а также делает возможными дополнительные интеграционные решения для доступа конечных пользователей. Knox реализует единую точку безопасного доступа к Hadoop-кластерам в виде шлюза (или небольшого кластера шлюзов), который представляет доступ через REST API. Этот шлюз поддерживает брандмауэр между Hadoop-кластерами и пользователями и позволяет управлять доступом к кластерам с разными версиями Hadoop, в т.ч. отделенными друг от друга сетевыми брандмауэрами [1].

С точки зрения корпоративной ИТ-инфраструктуры, Apache Knox упрощает использование Big Data, позволяя расширять доступ новых пользователей к Hadoop, а также поддерживая соответствие корпоративных политик безопасности. Инструмент интегрируется с распространенными системами управления идентификацией, технологией единого входа (Single Sign-On, SSO) и позволяет использовать идентификационные данные из корпоративных систем для безопасного доступа к кластерам Hadoop [2].

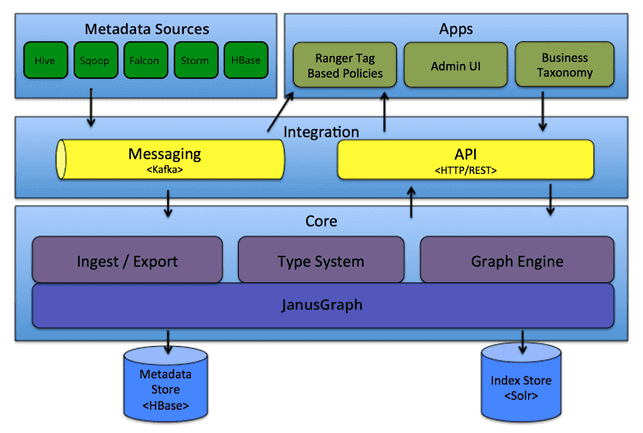

Комплексная интеграция корпоративных систем и данных с Apache Atlas

Apache Atlas – это масштабируемый и расширяемый набор базовых сервисов управления, позволяющий эффективно и безопасно интегрировать Hadoop со всей экосистемой корпоративных данных [3]. Этот инструмент предоставляет следующие возможности:

- управление метаданными для создания каталога корпоративных активов данных;

- классификация и управление корпоративными активами данных, включая совместную работу над ними;

- REST API для упрощения интеграции инфраструктуры Big Data на основе кластера Hadoop с другими корпоративными информационными системами, а также для доступа к истории обновления данных (data lineage);

- отображение data lineage в графическом интерфейсе пользователя;

- авторизация доступа к данным на основе заданных классификаций за счет интеграции с Apache Ranger;

- расширенный поиск объектов по типу, классификации, значению атрибута, свободному тексту или более сложным критериям, в т.ч. с помощью SQL-подобного языка запросов, специфичного для предметной области (DSL – Domain Specific Language).

Комплексное управление безопасностью кластера Hadoop с Apache Ranger

Apache Ranger – это инфраструктура для обеспечения, мониторинга и управления комплексной безопасностью данных на платформе Hadoop [5], которая реализует:

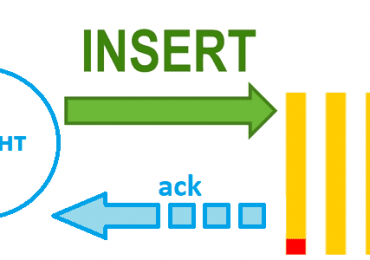

- централизованное администрирование для управления всеми задачами, связанными с безопасностью, в интерфейсе пользователя или с помощью API REST;

- центральное управление политиками для контроля доступа к файлам, папкам, базам данных, таблицам, столбцам на HDFS, Hive и Hbase, Knox, Solr, Kafka, и YARN;

- детальную авторизацию для выполнения действий с компонентами или инструментами Hadoop и управление с помощью централизованного администрирования;

- стандартизированный метод авторизации для всех компонентов Hadoop;

- расширенную поддержку различных методов авторизации (управление доступом на основе ролей, атрибутов и т. д.).

Также Apache Ranger включает средство мониторинга экосистемы Hadoop, позволяющее в режиме реального времени отслеживать все запросы доступа, и поддерживает несколько источников назначения, включая HDFS и Solr [2]. Подробнее о применении Apache Ranger как комплексного средства обеспечения безопасности отечественной корпоративной платформы сбора и хранения данных Arenadata Enterprise Data Platform читайте здесь.

Как настроить, администрировать и использовать все эти и другие средства защиты кластера хадуп на практике, мы детально рассматриваем в курсе DSEC: Безопасность озера данных Hadoop в нашем специализированном учебном центре обучения пользователей, инженеров, администраторов и аналитиков Big Data в Москве.

Источники