Содержание

- Ключевые аспекты и архитектура Apache Kafka

- Брокеры (Brokers)

- Топики (Topics)

- Разделы (Partitions)

- Репликация (Replication)

- Производители (Producers)

- Потребители (Consumers)

- Admin API

- ZooKeeper и KRAFT

- Принцип работы Apache Kafka/Механизм

- Примеры использования Apache Kafka/Сценарии применения

- Экосистема Apache Kafka: Kafka Streams, Kafka Connect

- Kafka Streams

- Kafka Connect

- Основные дистрибутивы и расширения Apache Kafka

- Основные конкуренты Apache Kafka

- Использованные источники и материалы:

Apache Kafka – это высокопроизводительная распределенная потоковая платформа с открытым исходным кодом, разработанная изначально в LinkedIn, которая позволяет приложениям публиковать, подписываться, хранить и обрабатывать потоки записей в реальном времени, обеспечивая при этом высокую пропускную способность, масштабируемость и отказоустойчивость для широкого круга сценариев использования, включая обработку больших данных и микросервисные архитектуры.

Эта платформа функционирует как распределенный журнал транзакций. Она способна обрабатывать триллионы событий в день. Таким образом, Kafka стала стандартом де-факто для построения потоковых конвейеров данных. Она используется многими крупными компаниями. Ее надежность и производительность делают ее идеальным решением для современных распределенных систем.

Ключевые аспекты и архитектура Apache Kafka

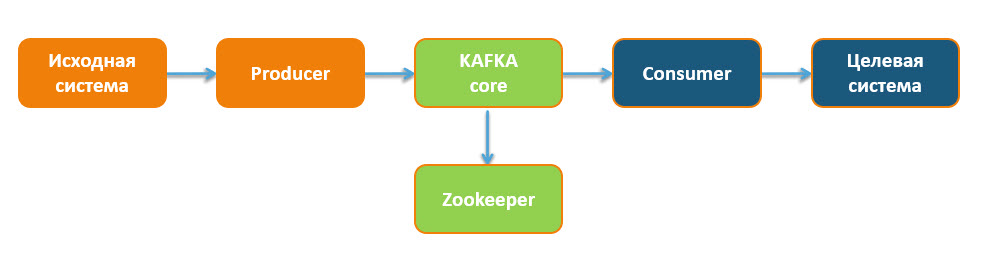

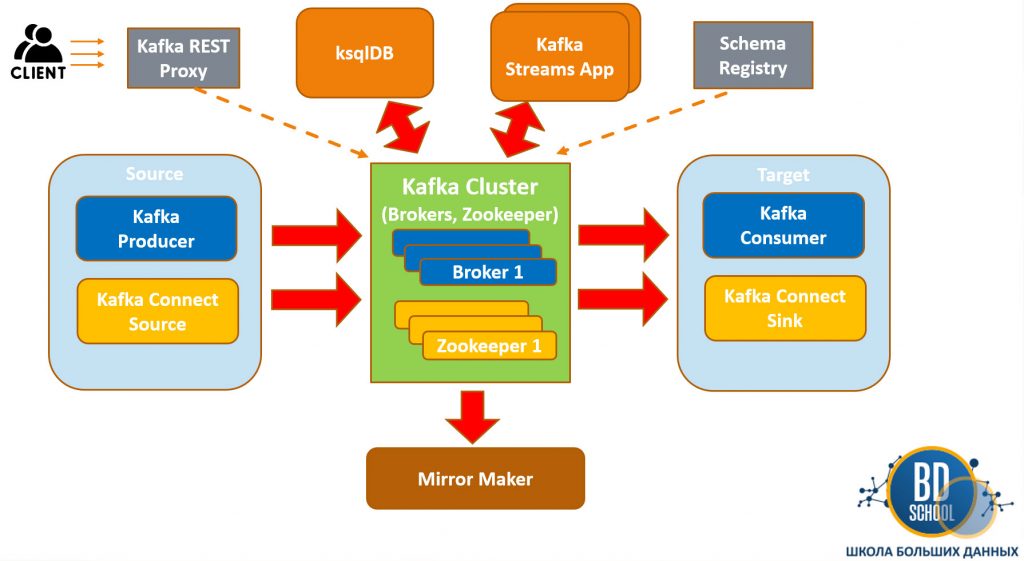

Архитектура Kafka включает несколько основных компонентов. Все они работают вместе для обеспечения её функциональности.

Брокеры (Brokers)

Брокеры — это серверы. Они образуют кластер Kafka. Каждый брокер хранит данные топиков. Он обрабатывает запросы производителей и потребителей. Кластер состоит из одного или нескольких брокеров. При этом данные распределяются между ними. Брокеры реплицируют данные. Это обеспечивает отказоустойчивость. Следовательно, сбой одного брокера не приводит к потере данных.

Apache Kafka: администрирование кластера

Код курса

KAFKA

Ближайшая дата курса

18 марта, 2026

Продолжительность

24 ак.часов

Стоимость обучения

76 800

Топики (Topics)

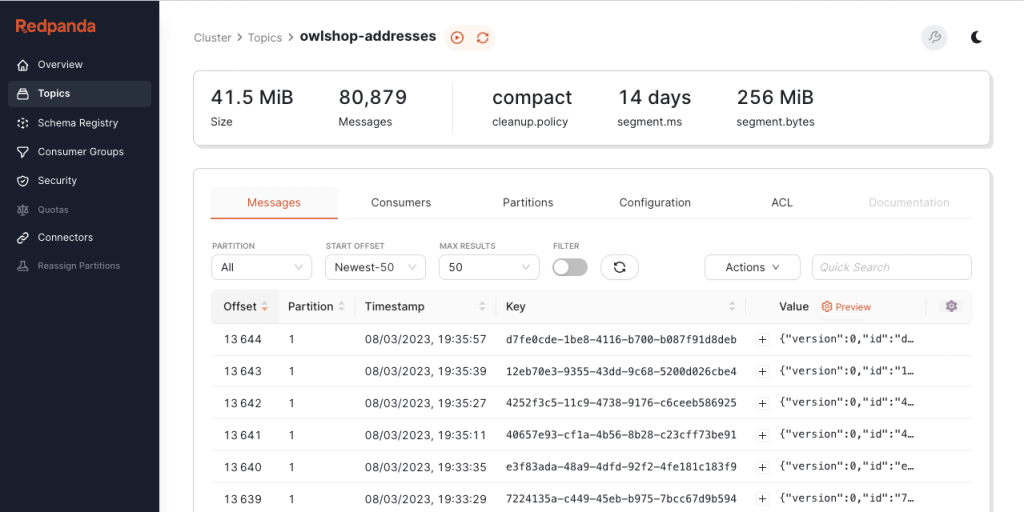

Kafka Топик — это логическая категория или канал. Он используется для публикации и подписки на сообщения. Топики аналогичны таблицам в базе данных. Каждый топик имеет уникальное имя. Сообщения внутри топика упорядочены по времени их поступления. Это фундаментальная единица организации данных.

Разделы (Partitions)

Каждый топик делится на разделы (partitions). Раздел — это упорядоченный, неизменяемый журнал записей. Сообщения внутри раздела получают последовательный идентификатор, смещение (offset). Разделы позволяют платформе масштабироваться горизонтально. Данные топика могут быть распределены по нескольким брокерам. Чем больше разделов, тем выше параллелизм. Каждый раздел может иметь несколько реплик для отказоустойчивости.

Репликация (Replication)

Для обеспечения отказоустойчивости каждый раздел может быть реплицирован на несколько брокеров. Количество копий раздела называется фактором репликации. Одна из реплик становится лидером (leader). Остальные — последователями (followers). Только лидер обрабатывает операции записи и чтения. Последователи синхронизируются с лидером. Если лидер выходит из строя, один из последователей становится новым лидером. Это гарантирует доступность данных.

Производители (Producers)

Kafka Producer — это клиентское приложение или программный компонент. Он предназначен для отправки сообщений в топики. Производители публикуют записи. Эти записи состоят из ключа, значения и опциональных заголовков. Они могут отправлять сообщения синхронно или асинхронно. Producer API предоставляет гибкие настройки для гарантий доставки (acks). Также он управляет партиционированием сообщений. Таким образом, Producer является источником данных для потоковой платформы.

Потребители (Consumers)

Kafka Consumer — это клиентское приложение или программный компонент. Он предназначен для чтения сообщений из топиков. Потребители работают в составе групп потребителей (consumer groups). В рамках одной группы каждый раздел топика читается только одним потребителем. Это обеспечивает масштабируемость и отказоустойчивость. Consumer отслеживает свое смещение (offset). Это позволяет возобновить чтение с последнего обработанного сообщения после перезапуска. Потребители используют Consumer API для взаимодействия с кластером.

Admin API

Для управления объектами кластера, такими как топики, брокеры и конфигурации, используется Admin API. Этот API предоставляет программный доступ к административным функциям. Он позволяет автоматизировать операции развертывания и мониторинга. Это делает управление кластером более эффективным.

ZooKeeper и KRAFT

Традиционно, Apache ZooKeeper использовался для хранения метаданных кластера Kafka. Он отвечал за управление брокерами, топиками и группами потребителей. Однако, начиная с версии Kafka 2.8, и особенно с полной реализацией в версии 4.0, платформа переходит на новый режим консенсуса — KRAFT (Kafka Raft Metadata). KRAFT полностью устраняет зависимость от ZooKeeper. Это упрощает архитектуру и развертывание кластера. Такая миграция делает управление более простым и производительным. Режим KRAFT встроен непосредственно в брокеры Kafka.

Apache Kafka: администрирование кластера

Код курса

KAFKA

Ближайшая дата курса

18 марта, 2026

Продолжительность

24 ак.часов

Стоимость обучения

76 800

Принцип работы Apache Kafka/Механизм

Принцип работы Kafka основывается на концепции распределенного журнала транзакций. Когда Producer отправляет сообщение, оно направляется на один из брокеров. Сообщение записывается в журнал определенного раздела топика. Каждая запись в разделе получает уникальное, последовательное смещение. После записи, брокеры реплицируют сообщение на другие брокеры в кластере. Это зависит от фактора репликации топика. Таким образом, обеспечивается сохранность данных. Consumer, подписанный на топик, опрашивает брокеры на наличие новых сообщений. Он получает сообщения из назначенных ему разделов. После обработки сообщения, потребитель фиксирует свое смещение. Это указывает на прогресс чтения. Если потребитель выходит из строя, другой потребитель в той же группе может продолжить чтение с последнего зафиксированного смещения. Это гарантирует отсутствие потери данных и их однократную обработку.

Примеры использования Apache Kafka/Сценарии применения

Kafka нашла широкое применение во многих областях. Это связано с её способностью эффективно обрабатывать потоки данных. Ниже приведены некоторые типичные сценарии:

- Построение потоковых данных (Data Pipelines): Платформа выступает в роли центральной шины для перемещения данных между различными системами. Например, из баз данных в аналитические хранилища. Это позволяет создавать гибкие и масштабируемые конвейеры.

- Сбор метрик и мониторинг: Компании используют Kafka для агрегации операционных данных и метрик из распределенных приложений. Затем эти данные анализируются в реальном времени для мониторинга состояния системы.

- Потоковая аналитика (Stream Analytics): Платформа является основой для решений потоковой обработки данных, таких как Apache Flink или Kafka Streams. Она позволяет выполнять аналитику и принимать решения на лету.

- Обмен сообщениями между микросервисами: В архитектурах микросервисов Kafka используется для асинхронной коммуникации. Это снижает связанность между сервисами и повышает их отказоустойчивость.

- Отслеживание активности пользователей (Activity Tracking): Веб-сайты и мобильные приложения отправляют события пользовательской активности (клики, просмотры, покупки) в Kafka. Эти данные затем используются для персонализации, аналитики и рекомендаций.

- Репликация баз данных (Change Data Capture — CDC): Изменения в базах данных могут быть захвачены и отправлены в Kafka. Это позволяет синхронизировать данные между различными системами в реальном времени.

Экосистема Apache Kafka: Kafka Streams, Kafka Connect

Помимо основных компонентов (брокеры, производители, потребители), Kafka имеет богатую экосистему. Она расширяет её возможности. Это делает платформу еще более мощной.

Kafka Streams

Kafka Streams — это клиентская библиотека. Она предназначена для построения потоковых приложений и микросервисов. Она позволяет обрабатывать данные, хранящиеся в Kafka, в реальном времени. Разработчики могут выполнять сложные операции. Например, это фильтрация, агрегация, объединение потоков данных. Kafka Streams упрощает разработку потоковых приложений. Она использует концепции из базы данных, такие как таблицы и журналы. Kafka Streams обрабатывает данные напрямую из топиков. Она записывает результаты обратно в Kafka. Таким образом, это эффективный инструмент для потоковой обработки.

Kafka Connect

Kafka Connect — это фреймворк. Он предназначен для масштабируемой и надежной потоковой передачи данных. Это происходит между Kafka и другими системами. Он упрощает интеграцию данных. Kafka Connect имеет два основных типа коннекторов: Source Connectors и Sink Connectors. Source Connectors импортируют данные из внешних систем в Kafka. Например, из баз данных, файловых систем. Sink Connectors экспортируют данные из Kafka во внешние системы. Например, в хранилища данных, поисковые движки. Kafka Connect позволяет избежать написания кастомного кода для интеграции. Это значительно ускоряет разработку ETL-процессов.

Основные дистрибутивы и расширения Apache Kafka

Хотя Kafka является проектом с открытым исходным кодом, существует несколько коммерческих дистрибутивов и платформ, которые добавляют дополнительные функции, инструменты управления и поддержку. Эти дистрибутивы значительно упрощают развертывание и эксплуатацию Kafka в производственной среде.

- Confluent Platform: Это одна из самых популярных коммерческих платформ. Confluent Platform предоставляет расширенные возможности. Среди них — Confluent Schema Registry, Confluent Control Center. Она также включает ksqlDB и дополнительные коннекторы. Confluent предлагает полную экосистему вокруг Kafka.

- Arenadata Streaming (ADS): Российский дистрибутив Kafka. Arenadata Streaming предоставляет корпоративную поддержку. Он включает дополнительные инструменты для управления и мониторинга. ADS ориентирован на использование в российских IT-инфраструктурах.

Основные конкуренты Apache Kafka

На рынке потоковой обработки данных у Kafka есть несколько ключевых конкурентов. Каждый из них имеет свои сильные стороны. Выбор зависит от конкретных требований проекта.

- RabbitMQ: Это популярный брокер сообщений. RabbitMQ использует протокол AMQP. Он часто применяется для обмена сообщениями между микросервисами. Однако RabbitMQ лучше подходит для очередей сообщений. Он менее масштабируем для потоковой передачи больших объемов данных.

- Apache Pulsar: Еще одна распределенная потоковая платформа. Apache Pulsar поддерживает как очереди, так и потоки. Он имеет многоуровневую архитектуру хранения. Pulsar предлагает гибкую масштабируемость. Он является серьезным конкурентом в области потоковых данных.

- Amazon Kinesis: Управляемый сервис потоковой передачи данных от AWS. Amazon Kinesis предоставляет возможности для сбора, обработки и анализа потоковых данных. Он полностью интегрирован с другими сервисами AWS. Однако Kinesis является проприетарным решением.

Использованные источники и материалы:

1475

1475