До сих пор мы рассматривали ClickHouse как самостоятельную систему: создавали в нем таблицы и загружали данные. Однако в реальном мире данные редко живут в одном месте. Транзакционная информация находится в реляционных базах вроде MySQL или PostgreSQL, архивы логов — в объектных хранилищах типа Amazon S3, а потоки событий в реальном времени — в Apache Kafka. Перемещать все эти данные в ClickHouse с помощью сложных ETL-процессов — долго и дорого. К счастью, ClickHouse спроектирован как открытый аналитический хаб и умеет работать с внешними данными напрямую. В этой статье мы рассмотрим самые важные механизмы интеграции, которые превращают ClickHouse из просто быстрой базы данных в центр вашей аналитической экосистемы.

Движки для внешних баз данных: Запросы без перемещения

Частая задача — объединить аналитические данные из ClickHouse (например, логи событий) со справочной информацией из основной, транзакционной базы данных. ClickHouse позволяет делать это «на лету» с помощью специальных движков таблиц. Как это работает? Вы создаете в ClickHouse таблицу, которая не хранит данные сама, а выступает в роли «прокси» или коннектора к таблице во внешней базе. Каждый раз, когда вы делаете SELECT к такой таблице, ClickHouse перенаправляет запрос во внешнюю систему.

Пример: Подключение к MySQL

Предположим, в MySQL у нас есть таблица users с информацией о пользователях. Создадим ее «отражение» в ClickHouse:

CREATE TABLE users_from_mysql (

user_id UInt64,

user_name String,

registration_date Date

)

ENGINE = MySQL('mysql_host:3306', 'mysql_db', 'users', 'mysql_user', 'password');

Важные оговорки:

Производительность: Этот способ не предназначен для высоконагруженных запросов к внешней базе. Он отлично подходит для JOIN‘ов с небольшими справочниками.

Predicate pushdown: ClickHouse старается «проталкивать» WHERE условия во внешнюю базу, чтобы фильтровать данные на ее стороне, но это работает не для всех типов запросов.

Интеграция ClickHouse при работе с файлами в S3: Анализируем архивы на месте

Объектные хранилища, такие как Amazon S3, — популярное место для хранения огромных архивов логов. Загружать терабайты таких данных в ClickHouse для разового анализа неэффективно. И этого не нужно делать! Интеграция ClickHouse может помочь выполнять запросы напрямую к файлам в S3 с помощью табличной функции s3()

Пример: Запрос к CSV файлу в S3

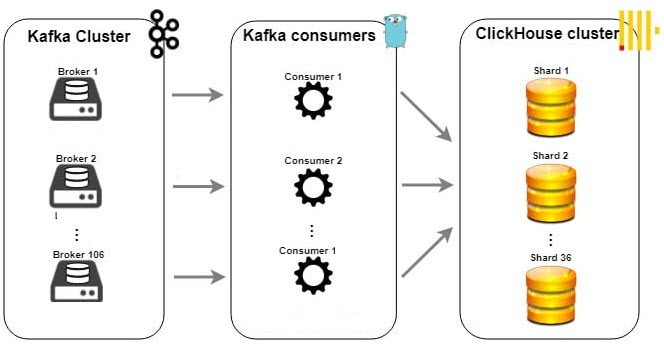

Потоковая обработка: Интеграция ClickHouse с Apache Kafka

Для аналитики в реальном времени данные часто поступают через брокеры сообщений, и Apache Kafka — самый популярный из них. ClickHouse имеет нативный движок Kafka для создания эффективных real-time пайплайнов. Более подробно мы рассматриваем примеры построения pipelinов на наших курсах, посвященных созданию хранилищ данных на ClickHouse и Kafka для инженеров данных

Архитектура пайплайна:

Стандартный подход состоит из трех компонентов:

Таблица с движком Kafka: Она подключается к топику Kafka и работает как потребитель (consumer).

Целевая таблица с движком MergeTree: Это основная, оптимизированная таблица, где данные будут храниться постоянно.

Материализованное представление (Materialized View): Это «клей», который автоматически читает новые данные из таблицы Kafka и вставляет их в таблицу MergeTree.

Теперь любой JSON, отправленный в топик в Kafka, будет автоматически распарсен и практически мгновенно попадет в нашу основную аналитическую таблицу.

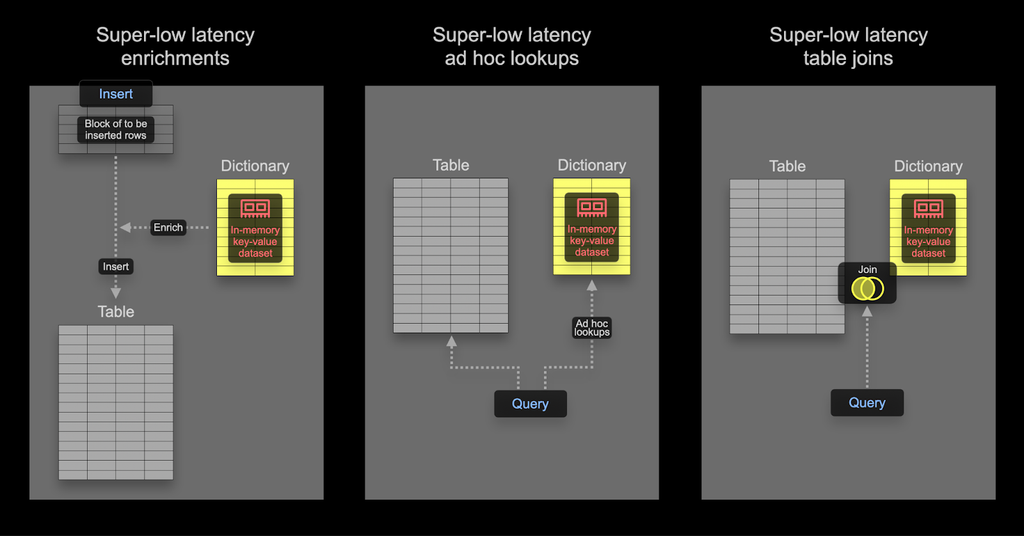

Обогащение данных: Внешние словари

Еще одна частая задача — обогащение данных. Ваши основные таблицы содержат идентификаторы (user_id), а в отчетах нужны имена (user_name). Делать JOIN каждый раз может быть неэффективно.

Решение — внешние словари. Это справочники (key-value), которые ClickHouse подгружает из внешнего источника и кэширует в оперативной памяти для сверхбыстрого доступа.

Как это работает? Для этого Вам нужно описать словарь (в XML или DDL), указывая его структуру, источник (например, таблица в MySQL) и правила обновления. В запросах вы используете специальную функцию dictGet() для получения значения по ключу. Функция dictGet() работает невероятно быстро, так как обращается к данным в оперативной памяти.

Заключение

Бесспорно, ClickHouse — это не изолированная база данных, а мощный аналитический процессор. Освоив эти инструменты интеграции ClickHouse, вы сможете решать гораздо более широкий класс задач, сокращая затраты на разработку сложных ETL-пайплайнов и строя по-настоящему современные аналитические системы.

Использованные референсы и материалы

- Официальный сайт Apache Kafka.

- Документация ClickHouse по табличной функции s3().

- Документация ClickHouse по Внешним словарям.

- Статья HTTP Analytics for 6M requests per second using ClickHouse на Cloudflare

SQL-блокнот к Уроку 7 бесплатного курса доступен в нашем репозитории на GitHub

Урок 1. Что такое ClickHouse: Полный гид по колоночной СУБД для сверхбыстрой аналитики.

Урок 2. Выбрать Типы данных и движки в ClickHouse: Фундамент для производительности.

Урок 3. Основы работы с данными в ClickHouse: вставка, выборка и первые аналитические запросы.

Урок 4. Продвинутые функции SQL в ClickHouse: обработка строк, дат и условная логика.

Урок 5. Глубокое погружение в движки MergeTree: Replacing, Summing, Aggregating и Collapsing.

Урок 6. Оптимизация запросов в ClickHouse: индексы, EXPLAIN и лучшие практики.

Урок 7. Интеграции ClickHouse: работа с MySQL, S3, Kafka и внешними словарями.

Урок 8. Аналитические суперсилы ClickHouse: Оконные функции и работа с массивами.

Урок 9. Администрирование и мониторинг ClickHouse: от системных таблиц до бэкапов.

Урок 10. Изучение ClickHouse: Итоги курса и следующие шаги в мире больших данных.

1216

1216