Содержание

- Business Intelligence — это не отчеты. Это компас для вашего бизнеса

- Архитектура современного аналитического хранилища

- Прощай, on-premise. Здравствуй, Cloud DWH

- Моделирование для аналитики — Кимбалл все еще жив

- Современный BI-стек: инструменты демократизации данных

- Трансформация данных (буква "Т" в ELT) — dbt

- Визуализация — Tableau, Power BI, Superset

- Self-Service BI — великая сила и великая ответственность

- Кейс из реальной жизни: как SaaS-компания дала клиентам "суперсилу"

- Заключение и анонс

- Рекомендованные материалы

Business Intelligence — это не отчеты. Это компас для вашего бизнеса

Представьте себя капитаном большого корабля в открытом море во время шторма. Как вы будете прокладывать курс? Полагаясь на интуицию и старые карты, нарисованные от руки? Возможно, вам повезет. Но скорее всего, вы налетите на рифы или заблудитесь. А теперь представьте, что у вас есть GPS, радар, сонар и спутниковая метеосводка. Ваши шансы на успех резко возрастают.

Управлять современным бизнесом без Business Intelligence (BI) — это и есть то самое плавание с завязанными глазами. BI — это не просто «отчеты для начальства». Это ваша навигационная система, ваш компас и радар, которые превращают интуитивные догадки в решения, основанные на фактах. Хранилища данных (Data Warehousing) — это двигатель и топливный бак для этой системы, которые собирают и подготавливают информацию для путешествия.

Долгое время этот «компас» был доступен только избранным. Бизнес-пользователь писал ТЗ на новый отчет. IT-отдел ставил задачу в очередь. Через несколько недель аналитики наконец-то его делали. К моменту, когда отчет попадал на стол заказчику, он уже был неактуален, а у бизнеса появлялись пять новых вопросов, и все начиналось по кругу.

К счастью, эта эпоха уходит в прошлое. На смену статичным отчетам пришли интерактивные дашборды, доступные 24/7. А главное — произошла «демократизация данных». Благодаря концепции Self-Service BI, любой менеджер или маркетолог, не обладающий навыками программирования, может сам, в режиме drag-and-drop, «крутить» данные, строить графики и находить ответы на свои вопросы. В этой статье мы разберемся, как устроены современные аналитические платформы и какие инструменты позволяют превратить данные в реальные инсайты.

Архитектура современного аналитического хранилища

Фундаментом любой BI-системы является хранилище данных, специально спроектированное для быстрого аналитического доступа. И за последние 10 лет архитектура этих хранилищ изменилась до неузнаваемости.

Прощай, on-premise. Здравствуй, Cloud DWH

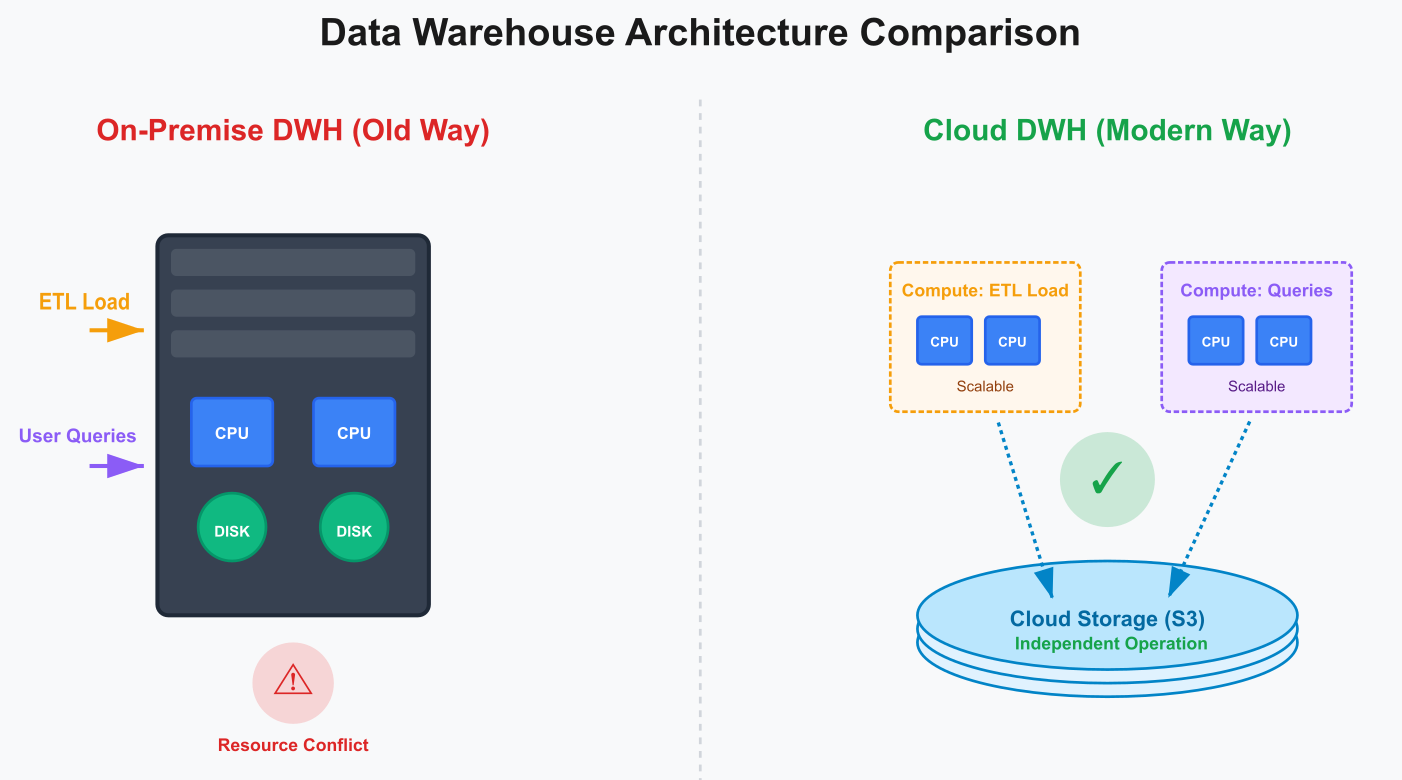

Классические корпоративные хранилища данных (DWH) от гигантов вроде Oracle или Teradata были мощными, но страдали от одной фундаментальной проблемы. Они были построены на «связанной» архитектуре (compute-storage coupling), где вычислительные ресурсы и диски для хранения были жестко спаяны в одном дорогом сервере. Это приводило к проблемам.

- Конфликт нагрузок Ночная загрузка данных (ETL) «отжирала» ресурсы и мешала аналитикам строить отчеты.

- Дорогое масштабирование Если вам не хватало либо места для хранения, либо мощности для вычислений, вам приходилось покупать еще один такой же дорогой сервер целиком.

Революцию произвели облачные хранилища данных (Cloud DWH), построенные на принципиально иной архитектуре — с разделением хранения и вычислений (storage-compute decoupling).

- Хранение Все данные лежат в виде файлов в открытых форматах (Parquet, ORC) в дешевом, надежном и практически бесконечном объектном хранилище (Yandex S3, Google Cloud Storage).

- Вычисления Для обработки запросов по требованию «поднимаются» виртуальные вычислительные кластеры. Нужен отчет для 1000 пользователей? Облако автоматически выделит мощный кластер. Отчет построен? Кластер «засыпает», и вы перестаете за него платить.

Такой подход позволил одновременно и загружать огромные объемы данных, и обслуживать тысячи аналитических запросов, не мешая друг другу.

- Примеры Snowflake, Google BigQuery, ClickHouse.

Моделирование для аналитики — Кимбалл все еще жив

Как мы уже обсуждали в статье про моделирование, для аналитики нужна денормализация. Самой популярной, простой и эффективной методикой для этого уже много лет остается подход Ральфа Кимбалла, основанный на схеме «звезда» (star schema).

Эта модель интуитивно понятна бизнес-пользователям, потому что она отражает то, как они мыслят. Она состоит из двух типов таблиц.

Таблица фактов (Fact table). Это сердце нашей «звезды». Она содержит цифры, описывающие бизнес-события. Например, для факта «Продажа» это будут Количество_товара, Сумма_продажи, Сумма_скидки. Факты — это то, что мы хотим измерять, агрегировать, суммировать.

Таблицы измерений (Dimension tables). Это лучи нашей «звезды». Они содержат контекст, описательные атрибуты, по которым мы хотим «резать» и фильтровать наши факты. Для факта «Продажа» это будут измерения Товары (с атрибутами Название, Категория, Бренд), Клиенты (Имя, Город, Сегмент), Календарь (День недели, Месяц, Год), Магазины (Название магазина, Регион).

BI-инструменты просто обожают такую структуру. Она позволяет им строить быстрые и предсказуемые SQL-запросы, давая пользователю возможность «проваливаться» (drill-down) от года к месяцу, от категории товара к конкретному бренду.

Современный BI-стек: инструменты демократизации данных

Современная аналитическая платформа — это не один монолитный продукт, а набор инструментов, каждый из которых решает свою задачу. Этот набор часто называют «Modern Data Stack».

Трансформация данных (буква «Т» в ELT) — dbt

Мы уже знаем, что в облачных хранилищах доминирует подход ELT, где трансформация происходит после загрузки данных. Настоящим катализатором этого подхода стал инструмент dbt (data build tool).

Если говорить просто, dbt — это «SQL на стероидах». Он позволил аналитикам, которые знают только SQL, делать то, что раньше было доступно только опытным дата-инженерам.

- Строить сложные конвейеры трансформации данных (например, переход от «бронзовой» к «серебряной» и «золотой» зонам в Lakehouse) с помощью одних лишь SQL-запросов.

- Работать с кодом как разработчики Использовать системы контроля версий (Git), писать тесты на качество данных, генерировать документацию.

Феномен dbt в том, что он вернул власть над данными из рук инженеров в руки аналитиков — людей, которые лучше понимают бизнес-смысл этих данных.

Визуализация — Tableau, Power BI, Superset

Это вершина айсберга, тот самый «компас», который видит конечный бизнес-пользователь. Сегодня на рынке доминируют несколько крупных игроков.

- Tableau Исторически считается самым мощным и гибким инструментом именно для визуализации. Его сильная сторона — способность создавать очень красивые, сложные и интерактивные дашборды.

- Microsoft Power BI Главный козырь — глубочайшая интеграция со всей экосистемой Microsoft. Если ваша компания живет в мире Windows, Office 365, Azure и Active Directory, то Power BI, скорее всего, будет для вас самым естественным и удобным выбором.

- Apache Superset Мощное, быстро развивающееся и абсолютно бесплатное open-source решение, которое по функциональности уже догоняет коммерческих гигантов. Отличный выбор для стартапов и компаний, которые хотят избежать вендорной зависимости.

Self-Service BI — великая сила и великая ответственность

Связка мощного облачного DWH и простого в освоении BI-инструмента породила феномен Self-Service BI («самообслуживаемая» аналитика). Это концепция, при которой любой менеджер, маркетолог или продакт-менеджер может, не дожидаясь IT, сам подключиться к данным и построить нужный ему отчет.

Плюсы очевидны и огромны.

- Скорость Время от вопроса до ответа сокращается с недель до минут.

- Снятие нагрузки с IT Аналитики перестают быть «фабрикой отчетов» и могут сфокусироваться на сложных задачах.

- Вовлеченность Бизнес-пользователи начинают лучше понимать свои данные и активнее их использовать.

Но есть и огромные риски. Если пустить все на самотек, компания быстро скатится в хаос, когда каждый отдел будет считать метрики по-своему, на основе своих собственных, «кустарных» данных. Именно здесь на сцену снова выходит Data Governance. Self-Service Business Intelligence может работать только тогда, когда у пользователей есть доступ к сертифицированным, проверенным источникам данных, а в компании есть единый бизнес-глоссарий (в Data Catalog), который однозначно отвечает на вопрос «Что такое ‘Активный клиент’?».

Кейс из реальной жизни: как SaaS-компания дала клиентам «суперсилу»

Давайте посмотрим, как эти концепции могут стать не просто внутренней системой, а частью продукта.

Ситуация (Проблема)

B2B SaaS-компания, предоставляющая популярную платформу для email-маркетинга, столкнулась с «проклятием» собственного успеха. Их продукт был хорош, но клиенты постоянно требовали больше аналитики. Стандартного набора отчетов («процент открытий», «процент кликов») им уже не хватало. Каждый день в поддержку сыпались запросы.

- «А можно посмотреть конверсию в разрезе пользователей, которые пришли с Android?»

- «А как сравнить эффективность промо-кампаний за прошлый и позапрошлый квартал по дням недели?»

Отдел разработки был завален задачами на создание кастомных отчетов и просто не успевал развивать основной продукт.

Решение (Внедрение Embedded Analytics)

Компания приняла гениальное решение — перестать давать клиентам «рыбу» и вручить им «удочку».

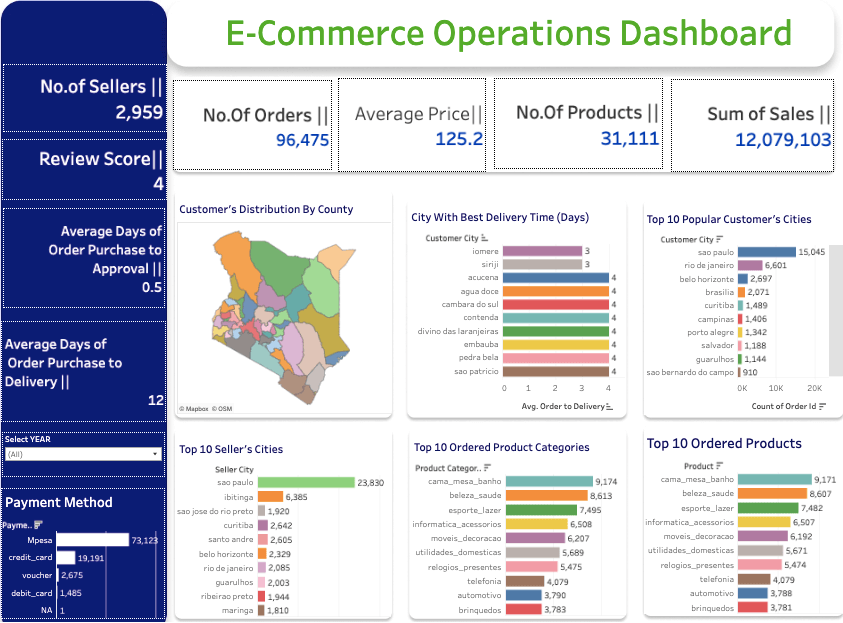

- Персональные DWH Для каждого клиента в облаке Google Cloud автоматически создавалось его собственное, изолированное аналитическое хранилище данных на базе Google BigQuery.

- ELT-процессы Все данные клиента по его email-кампаниям в реальном времени загружались в это персональное хранилище.

- Встроенная аналитика (Embedded Analytics) Прямо в интерфейс своего продукта компания встроила (embedded) Business Intelligence -инструмент Apache Superset. Теперь у каждого клиента появлялась вкладка «Аналитика», где он мог в режиме drag-and-drop самостоятельно строить любые отчеты и дашборды на основе своих собственных, полных данных.

Результат

Это решение полностью изменило их бизнес.

- Конкурентное преимущество Расширенная аналитика стала их главным «киллером фич». Отток клиентов (churn rate) снизился на 20%, потому что они получали огромную дополнительную ценность.

- Снижение нагрузки Нагрузка на отдел разработки по задачам «сделайте нам отчет» снизилась на 70%, что позволило команде сфокусироваться на развитии основного продукта.

- Новый источник дохода Компания смогла запустить новый, более дорогой тарифный план «Enterprise» с еще более продвинутыми возможностями аналитики, что значительно увеличило средний чек.

Практическая архитектура данных

Код курса

PRAR

Ближайшая дата курса

20 апреля, 2026

Продолжительность

24 ак.часов

Стоимость обучения

76 800

Заключение и анонс

Современный BI — это уже не про отчеты для начальства. Это про культуру и инструменты, которые позволяют каждому сотруднику на своем месте принимать решения, основанные на данных. Переход к эластичным облачным DWH, простым и понятным моделям данных Кимбалла и интерактивным Self-Service BI-инструментам стал мощнейшим драйвером «демократизации данных» во всем мире.

Проектирование эффективных аналитических витрин по методологии Кимбалла, выбор правильного BI-инструмента и построение всего стека, от хранилища до дашборда — это классические задачи архитектора и аналитика данных. Понимание того, как создать не просто красивый график, а надежную, масштабируемую и управляемую аналитическую платформу, и является сутью практического обучения.

Мы построили прекрасную аналитическую систему. Но как пользователи узнают, каким данным в ней можно доверять? Откуда они на самом деле взялись? Что означает тот или иной показатель в отчете? В следующей статье мы поговорим про «карту и компас» нашего мира данных — Управление метаданными (Metadata Management).

Рекомендованные материалы

- DAMA-DMBOK (Глава 10 Data Warehousing and Business Intelligence).

- The Data Warehouse Toolkit by Ralph Kimball (библия по многомерному моделированию).

- Официальная документация Snowflake, Google BigQuery, ClickHouse.

- The dbt (data build tool) blog

995

995