Содержание

- Ключевые принципы эффективного Prompt engineering

- Механизм работы: Как Prompt engineering влияет на LLM

- Базовые и продвинутые техники Prompt engineering

- Prompt engineering vs. Context engineering

- Сценарии применения Prompt engineering

- Практические примеры Prompt engineering

- Пример 1: Zero-shot prompting (Простой приказ)

- Пример 2: Role Prompting (Улучшение качества и глубины)

- Пример 3: Few-shot prompting (Форматирование вывода)

- Примеры для API (Python/bash)

- Заключение

- Референсные ссылки

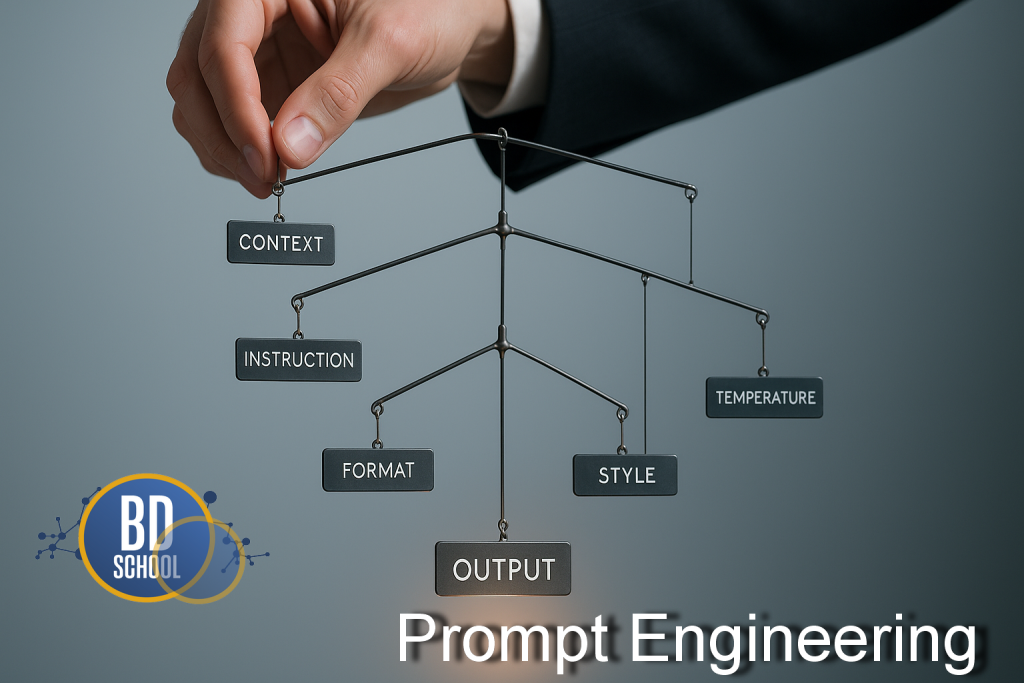

Prompt engineering (инженерия запросов) — это процесс проектирования, формулирования и итеративной оптимизации текстовых инструкций (промптов), направленных к большим языковым моделям (LLM) для получения точных, релевантных и контролируемых ответов.

Prompt Engineering (PE) включает в себя глубокое понимание того, как модель интерпретирует контекст, структурирует информацию и следует инструкциям. Как следствие, Prompt engineering позволяет управлять поведением ИИ и его результатами без изменения внутренней архитектуры самой модели. Значимость PE резко возросла с появлением моделей, буквально следующих инструкциям, таких как GPT-4. Эффективность ИИ-системы теперь зависит не только от мощности самой модели. Она в равной степени зависит от качества запроса. Плохое PE приводит к неверным или неполным результатам. Таким образом, Prompt engineering становится ключевым навыком для эффективного взаимодействия с современным искусственным интеллектом.

Ключевые принципы эффективного Prompt engineering

Эффективный Prompt engineering опирается на несколько фундаментальных принципов, которые помогают структурировать запрос таким образом, чтобы максимизировать вероятность получения желаемого ответа. Эти принципы особенно важны при работе с моделями, которые обучены точно следовать инструкциям.

Ясность и Специфичность

Это главный принцип PE. Модель не может читать мысли. Инструкции должны быть максимально однозначными и конкретными. Следует избегать расплывчатых формулировок. Например, вместо «Напиши о Kafka» (неясно) следует использовать «Напиши 500 слов, объясняющих роль Kafka в микросервисной архитектуре, для аудитории инженеров» (ясно и специфично). Чем меньше у модели пространства для интерпретации, тем точнее будет ответ.

Структура и Разделители

Современные LLM отлично понимают структуру. Качественное PE часто включает четкое разделение инструкции, контекста, примеров и входных данных. Это критически важно, когда в промпт подается много разной информации. Для разделения частей запроса рекомендуется использовать разделители. Это могут быть тройные обратные кавычки («`), XML-теги (<контекст>…</контекст>) или даже простые маркеры вроде `—`. Использование разделителей помогает модели точно понять, где заканчивается инструкция и начинаются данные для анализа.

Организация Промпта

Длина контекстного окна у моделей растет. Однако модели не всегда уделяют одинаковое внимание всем частям длинного промпта. Критически важные инструкции следует размещать в стратегических местах. Как правило, это начало промпта (для задания общей задачи) и конец промпта (для напоминания о финальном формате). Опытное Prompt engineering учитывает эти особенности «внимания» модели для управления результатом.

Механизм работы: Как Prompt engineering влияет на LLM

Prompt engineering — это не дополнительное обучение или донастройка (fine-tuning) модели. Это процесс, использующий фундаментальный механизм работы LLM, известный как In-Context Learning (ICL) или обучение в контексте. Модель использует предоставленный промпт как единственный источник информации для выполнения текущей задачи. Она учится «на лету» на основе примеров и инструкций, содержащихся в этом промпте.

Когда LLM генерирует ответ, она делает это последовательно, токен за токеном. Каждый следующий токен прогнозируется на основе всех предыдущих токенов. Prompt engineering работает, направляя этот вероятностный процесс.

Качественный промпт задает такое начальное состояние, при котором желаемая последовательность токенов (т.е. правильный ответ) становится наиболее вероятной. Например, простая фраза «Подумай шаг за шагом» является мощной техникой PE. Она заставляет модель сначала сгенерировать токены, описывающие рассуждения. Только после этого модель генерирует токены с финальным ответом. Этот процесс (Chain-of-Thought) меняет весь вычислительный путь модели. Таким образом, PE — это, по сути, управление процессом генерации токенов в реальном времени.

Базовые и продвинутые техники Prompt engineering

Prompt engineering охватывает широкий спектр техник, от очень простых до чрезвычайно сложных. Выбор техники зависит от задачи, возможностей модели и требуемой точности. Эти подходы можно условно разделить на две основные группы: базовые и продвинутые.

Базовые техники

Это фундаментальные методы PE, которые используются для большинства повседневных задач.

- Zero-shot prompting (Запрос без примеров). Это самая базовая форма PE. Мы просто даем модели инструкцию и ожидаем, что она ее выполнит, опираясь исключительно на свои предварительно обученные знания. Это хорошо работает для простых задач, таких как перевод, суммирование или ответы на общие вопросы.

- Role Prompting (Назначение роли). Эта техника значительно повышает качество ответа. Мы даем модели инструкцию, начиная с назначения ей конкретной роли (например, «Ты — опытный финансовый аналитик»). Это работает, потому что PE в данном случае сужает контекстуальное поле модели. Модель начинает генерировать текст, который с высокой вероятностью ассоциируется с указанной ролью, что приводит к более релевантному стилю и уровню экспертизы.

- Few-shot prompting (Запрос с несколькими примерами). Это прямая демонстрация механизма In-Context Learning. Вместо того чтобы просто описывать задачу, мы показываем модели несколько примеров ее выполнения. Например, для задачи классификации мы предоставляем 2-3 примера текста и правильную категорию. Модель выявляет закономерность из этих примеров и применяет ее к новым данным. Этот метод PE незаменим, когда требуется строгий формат вывода.

Продвинутые техники

Эти методы PE используются для решения сложных, многоэтапных или логических задач, требующих от модели рассуждений или использования внешних инструментов.

- Chain-of-Thought (CoT) Prompting (Метод «цепочки мыслей»). Это продвинутая техника PE, которая произвела революцию в решении сложных задач. Вместо того чтобы просить немедленный ответ, мы просим модель сначала «подумать вслух» или «рассуждать шаг за шагом». Это заставляет модель декомпозировать сложную проблему (например, математическую или логическую) на последовательность более простых шагов.

- Self-Consistency (Самосогласованность). Эта техника является расширением CoT. Вместо одного ответа, мы просим модель сгенерировать несколько разных «цепочек мыслей» для одной и той же задачи. Затем мы анализируем все полученные ответы. Тот ответ, который встречается чаще всего, выбирается как финальный. Это PE для повышения надежности критически важных выводов.

- Продвинутая структуризация (Agentic Prompts). Для очень сложных, многоэтапных задач (например, для ИИ-агентов) PE превращается в написание почти конфигурационного файла. Промпт четко структурируется с помощью разделителей на логические секции: # ИНСТРУКЦИИ, # ИНСТРУМЕНТЫ, # КОНТЕКСТ, # ПРИМЕРЫ ВЫПОЛНЕНИЯ. Такой структурированный подход позволяет модели четко следовать сложным рабочим процессам.

Выбор правильной техники Prompt engineering является ключом к раскрытию полного потенциала больших языковых моделей.

Prompt engineering vs. Context engineering

В экосистеме ИИ важно различать две тесно связанные, но разные дисциплины: Prompt engineering и Context engineering. Они часто используются вместе, но решают разные задачи.

Prompt engineering (Инженерия запросов), как мы уже установили, фокусируется на инструкции. Это искусство и наука о том, как мы формулируем задачу, какую роль назначаем, какие примеры (few-shot) предоставляем и как структурируем сам запрос, чтобы направлять поведение модели.

Context engineering (Инженерия контекста), с другой стороны, фокусируется на данных. Это дисциплина о том, что мы подаем в модель для работы. Это управление большими объемами внешней информации, которая должна быть загружена в контекстное окно модели вместе с промптом.

Наиболее ярким примером Context engineering является техника RAG (Retrieval-Augmented Generation). Прежде чем промпт будет отправлен LLM, система Context engineering сначала выполняет поиск по внешней базе данных и извлекает наиболее релевантные фрагменты информации. Эти фрагменты затем автоматически вставляются в промпт в качестве контекста.

Таким образом, Prompt engineering — это то, как мы пишем инструкцию (например, «Используя следующий контекст, ответь на вопрос пользователя»). Context engineering — это процесс, который находит и предоставляет этот самый контекст. Обе дисциплины критически важны для создания современных ИИ-приложений. Context engineering является отдельной и сложной темой, заслуживающей детального рассмотрения.

Сценарии применения Prompt engineering

Качественное Prompt engineering является необходимым условием для успешной работы широкого спектка приложений на базе LLM. Без него модели будут давать общие или нерелевантные ответы. Ниже представлен список ключевых сценариев применения.

- Создание персонализированных чат-ботов. С помощью PE (в частности, Role Prompting) чат-боту задается уникальная личность, стиль общения и база знаний, что позволяет ему выступать в роли технической поддержки, образовательного тьютора или бренд-ассистента.

- Автоматизация генерации кода. Продвинутые техники PE позволяют разработчикам генерировать сложный код, писать unit-тесты, проводить рефакторинг и даже переводить код с одного языка программирования на другой, предоставляя точные инструкции и контекст.

- Сложный анализ неструктурированных данных. Используя Few-shot prompting, компании могут настроить LLM для извлечения конкретных сущностей, классификации документов или анализа тональности из больших объемов текста (например, email, отзывов) в строго заданном формате, таком как JSON.

- Креативная генерация контента. PE используется маркетологами и авторами для создания черновиков статей, рекламных слоганов, сценариев и постов в социальных сетях, управляя тоном, стилем и длиной генерируемого материала.

- Использование LLM в научных исследованиях. Ученые применяют PE для анализа гипотез, суммирования больших объемов научной литературы и выявления скрытых закономерностей в данных, используя CoT для проверки сложных логических цепочек.

Этот список не является исчерпывающим. Фактически, любая задача, выполняемая LLM, требует той или иной формы Prompt engineering для достижения полезного результата.

Практические примеры Prompt engineering

Лучший способ понять силу PE — это увидеть, как разные техники решают одну и ту же задачу. Мы рассмотрим задачу анализа отзыва клиента в простом GUI (условный ChatGPT или Gemini). Эти примеры наглядно демонстрируют разницу в результатах и идеально подходят для иллюстрации скриншотами.

Сквозная задача: Проанализировать отзыв клиента:

«Обслуживание было медленным, но сама еда просто великолепна!»

Пример 1: Zero-shot prompting (Простой приказ)

Эта техника — просто прямой запрос без дополнительного контекста.

- Промпт:

Определи тональность этого отзыва: «Обслуживание было медленным, но сама еда просто великолепна!» - Типичный результат:

Тональность смешанная. - Вывод: Ответ правильный, но практически бесполезный для бизнеса.

Пример 2: Role Prompting (Улучшение качества и глубины)

Здесь мы используем PE, чтобы задать модели роль и цель.

- Промпт:

Ты — менеджер по контролю качества в ресторане. Твоя задача — извлекать из отзывов практическую пользу. Проанализируй этот отзыв и объясни, какие выводы должна сделать команда: «Обслуживание было медленным, но сама еда просто великолепна!» - Типичный результат:

Этот отзыв указывает на две ключевые зоны: \n1. Кухня: Отличная работа, качество еды высокое. Необходимо похвалить команду поваров. \n2. Обслуживание в зале: Критическая проблема. Медленная скорость обслуживания портит общее впечатление. Необходимо срочно проанализировать причины задержек. - Вывод: Ответ стал действенным и несет реальную бизнес-ценность.

Пример 3: Few-shot prompting (Форматирование вывода)

Здесь мы используем PE, чтобы «обучить» модель на лету и заставить ее выдавать ответ в строгом формате (например, для CRM или базы данных).

- Промпт:

Я перевожу отзывы в JSON. Вот примеры: \n \nПример 1: «Все было супер!» \n{«sentiment»: «positive», «area»: «general»} \n \nПример 2: «Официант пролил на меня суп.» \n{«sentiment»: «negative», «area»: «service»} \n \nТеперь обработай этот отзыв: «Обслуживание было медленным, но сама еда просто великолепна!» - Типичный результат:

{«sentiment»: «mixed», «area»: «service, food»} - Вывод: Модель точно скопировала требуемый формат вывода, который теперь можно автоматически обрабатывать.

Примеры для API (Python/bash)

Для разработчиков PE чаще всего происходит через API. Инструкции часто передаются в «system» сообщении, а данные пользователя — в «user» сообщении.

Пример 4: Chain-of-Thought (Python)

Этот пример показывает, как заставить модель рассуждать для решения логической задачи.

import openai

# Установка API-ключа (лучше делать через переменные окружения)

# client = openai.OpenAI(api_key="YOUR_API_KEY")

system_prompt = """

Ты — ассистент по решению математических задач.

Прежде чем дать финальный ответ, всегда подробно опиши всю цепочку своих рассуждений шаг за шагом.

"""

user_prompt = "У Джона 5 яблок. Он купил еще 3 коробки по 4 яблока в каждой. Сколько всего яблок у Джона?"

# Пример вызова API.

# Код закомментирован, так как для работы требует действующий API-ключ.

# completion = client.chat.completions.create(

# model="gpt-4",

# messages=[

# {"role": "system", "content": system_prompt},

# {"role": "user", "content": user_prompt}

# ]

# )

# print(completion.choices[0].message.content)

Пример 2: Структурированный вывод JSON (bash/cURL)

Этот пример PE использует системную инструкцию, чтобы гарантировать вывод в формате JSON.

# Пример вызова API через cURL

# (Требует наличия $OPENAI_API_KEY в переменных окружения)

curl [https://api.openai.com/v1/chat/completions](https://api.openai.com/v1/chat/completions) \

-H "Authorization: Bearer $OPENAI_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "gpt-4",

"messages": [

{

"role": "system",

"content": "Извлеки имя, фамилию и email из текста. Ответь только в формате JSON с ключами 'first_name', 'last_name', 'email'. Не добавляй никаких пояснений."

},

{

"role": "user",

"content": "Меня зовут Иван Петров, моя почта ivan.petrov@example.com, я хотел бы обсудить..."

}

],

"temperature": 0.1

}'

ИИ-агенты для оптимизации бизнес-процессов

Код курса

AGENT

Ближайшая дата курса

18 мая, 2026

Продолжительность

24 ак.часов

Стоимость обучения

66 000

Заключение

Prompt engineering — это не временный трюк или обходной путь. Это фундаментальный навык, представляющий собой основной интерфейс взаимодействия с одним из самых мощных инструментов, созданных человеком. По мере того, как большие языковые модели становятся более сложными, важность точных и эффективных инструкций будет только расти.

Будущее PE, вероятно, будет двигаться в сторону автоматизации. Уже появляются фреймворки (например, DSPy), которые пытаются программно оптимизировать промпты, превращая ручное Prompt engineering в более управляемый процесс. Однако, в то же время, фокус смещается на смежную дисциплину — Context engineering, которая отвечает за предоставление моделям актуальных и правильных данных для работы. Тем не менее, человеческий навык декомпозиции сложной задачи и ее ясного формулирования останется в основе эффективной работы с ИИ.

Референсные ссылки

- OpenAI GPT-4.1 Prompting Guide https://cookbook.openai.com/examples/gpt4-1_prompting_guide

- Prompt Engineering Guide https://www.promptingguide.ai/

- Vanderbilt University: PE Resources https://vanderbilt.edu/launch/prompt-engineering-resources/

- What is Context Engineering? https://context.ai/blog/what-is-context-engineering

- Chain-of-Thought Prompting Elicits Reasoning in Large Language Models (ArXiv) https://arxiv.org/abs/2201.11903

687

687