Содержание

- Проблематика: Зачем нужен MLOps?

- "Пропасть" между R&D и Production

- Деградация моделей (Model Drift / Decay)

- Проблемы масштабирования и поддержки

- Воспроизводимость и аудит (Reproducibility & Compliance)

- Ключевые принципы и цели MLOps

- Принцип работы и жизненный цикл MLOps (The MLOps Lifecycle)

- Сбор и инжиниринг данных (Data Engineering)

- Разработка и обучение модели (Model Training)

- Валидация и тестирование (Model Validation)

- Развертывание (Model Deployment)

- Мониторинг и эксплуатация (Model Monitoring)

- Переобучение (Retraining)

- Уровни зрелости MLOps

- Сценарии использования MLOps

- Инструменты для управление MLOps и технологический стек (с акцентом на российский рынок)

- Open Source (Основа для on-premise)

- Российские облачные платформы (ML PaaS)

- Роли и организационная структура

- Вызовы и будущие направления

- Референсные ссылки

MLOps (Machine Learning Operations) — это набор практик, методологий и философия, направленные на надежное, эффективное и масштабируемое развертывание и поддержку моделей машинного обучения (ML) в производственной среде. По своей сути, MLOps представляет собой применение принципов DevOps (таких как непрерывная интеграция, непрерывная доставка и автоматизация) к специфическим требованиям жизненного цикла систем машинного обучения.

Ключевая цель MLOps — объединить команды разработки (Data Science, ML-исследования) и эксплуатации (IT Operations), чтобы радикально сократить время вывода ML-решений на рынок и снизить операционные риски.

Основное и фундаментальное отличие MLOps от DevOps заключается в том, что MLOps цикл управляет не только кодом и инфраструктурой, но и третьей, уникальной и постоянно меняющейся компонентой — данными и моделями. Именно изменчивость данных и необходимость постоянного переобучения моделей создают те вызовы, которые MLOps призван решить. Без этого подхода процесс внедрения искусственного интеллекта становится хаотичным и трудноуправляемым. Таким образом, методология трансформирует экспериментальный код в надежный промышленный сервис.

Проблематика: Зачем нужен MLOps?

Появление MLOps как отдельной дисциплины было вызвано рядом системных проблем, с которыми компании сталкивались при попытке перевести модели машинного обучения из стадии исследования (R&D) в реальную эксплуатацию (Production).

«Пропасть» между R&D и Production

Самая частая проблема — так называемая «пропасть» между миром Data Science и миром IT-операций. Модель, которая показывает отличные метрики в Jupyter-блокноте на «ноутбуке» дата-сайентиста, часто оказывается совершенно не готова к реальному миру.

Различия в средах колоссальны: в R&D используются статичные, очищенные датасеты, в то время как в Production данные «живые», зашумленные и поступают в виде потока. Зависимости библиотек, версии Python, доступ к оборудованию (CPU vs GPU) — все это различается. Традиционно, этот переход выглядел как «перебрасывание» модели (часто в виде .pickle-файла) «через стену» к инженерам, что приводило к долгому процессу ручной интеграции, ошибкам и взаимному недовольству.

Деградация моделей (Model Drift / Decay)

Модель машинного обучения — это не статический артефакт. После развертывания ее точность неизбежно начинает снижаться со временем. Этот феномен называется деградацией или «дрейфом» модели.

- Data Drift (Дрейф данных): Это изменение статистических свойств входных данных, на которых работает модель. Например, если модель прогнозирования спроса на такси была обучена на данных до пандемии, ее прогнозы будут неверны в новых реалиях. Появление новых категорий товаров, изменение потребительского поведения, сезонность -все это дрейф данных.

- Concept Drift (Дрейф концепции): Это более сложный тип дрейфа, при котором меняется сама взаимосвязь между входными данными и целевой переменной. То, что раньше было надежным предиктором (например, «количество просмотров» предсказывало «покупку»), больше им не является из-за изменения логики рынка или появления нового конкурента.

Без MLOps-подхода отслеживание этой деградации и своевременное переобучение модели становятся невозможными.

Проблемы масштабирования и поддержки

Одно дело — вручную развернуть и поддерживать одну модель. Совсем другое — управлять парком из десятков или сотен моделей. Без стандартизированных MLOps-процессов это превращается в хаос.

Отсутствие единого подхода к развертыванию, мониторингу и логированию приводит к тому, что каждая новая модель требует непропорционально больших усилий для поддержки. Становится критически сложно отслеживать версии: какая именно версия модели сейчас работает в production? На каких данных она была обучена? Какой коммит кода использовался для ее обучения?

Воспроизводимость и аудит (Reproducibility & Compliance)

В производственной среде часто возникает необходимость в аудите или отладке. Например, регулятор (в банковской сфере) или клиент может задать вопрос: «Почему эта модель выдала именно такой прогноз для этого клиента?».

Без практик MLOps ответить на этот вопрос почти невозможно. Необходимость в воспроизводимости (Reproducibility) — то есть возможность в любой момент времени взять код, данные и параметры и получить точно такую же модель с теми же метриками является критической. Это также тесно связано с требованиями к объяснимости (XAI — Explainable AI) и проверке моделей на этическую предвзятость (Bias).

Ключевые принципы и цели MLOps

Внедрение MLOps требует понимания фундаментальных различий между классическим программным обеспечением и системами машинного обучения. В обычной разработке (DevOps) мы управляем только кодом. Однако в машинном обучении результат зависит от трех компонентов: кода, данных и модели. MLOps базируется на нескольких ключевых принципах, унаследованных от DevOps, но адаптированных под реалии ML.

Автоматизация (Automation)

Автоматизация — главный принцип MLOps. Цель — устранить как можно больше ручных шагов из всего жизненного цикла. Это включает в себя не только автоматизацию сборки и развертывания, но и автоматизацию тестирования. Причем в MLOps тестирование охватывает не только код (юнит-тесты), но также валидацию данных и тестирование самой модели на адекватность.

CI/CD/CT (Непрерывный цикл)

К классической связке CI/CD в MLOps добавляется третья, критически важная компонента — CT.

- CI (Continuous Integration / Непрерывная интеграция): В MLOps это больше, чем просто тестирование кода. Пайплайн CI должен включать автоматическую валидацию новых поступающих данных, проверку их схемы и тестирование компонентов (например, скриптов обработки фичей).

- CD (Continuous Delivery / Непрерывная доставка): Здесь речь идет об автоматизации сборки и развертывания не просто сервиса, а всего ML-пайплайна. Артефактом доставки становится не только упакованная модель, но и сам пайплайн, способный ее обучить.

- CT (Continuous Training / Непрерывное обучение): Это уникальный для MLOps принцип. Он подразумевает автоматический запуск процесса переобучения модели при выполнении определенных триггеров. Триггером может быть деградация качества модели в production (по данным мониторинга) или просто появление достаточного объема новых данных.

Мониторинг (Monitoring)

В MLOps мониторинг выходит далеко за рамки стандартных IT-метрик (uptime, latency, error rate). Ключевой фокус смещается на мониторинг качества модели и стабильности данных в production. Системы MLOps-мониторинга непрерывно отслеживают дрейф данных и дрейф концепции, чтобы вовремя подать сигнал о необходимости переобучения.

Версионирование (Versioning)

Для обеспечения воспроизводимости MLOps требует строгой системы версионирования, которую часто называют «святой троицей»:

- Версионирование кода (Git): Код для обучения, код для обработки данных, код пайплайнов.

- Версионирование данных (DVC, Pachyderm): Возможность «откатиться» к тому срезу данных, на котором была обучена конкретная модель.

- Версионирование моделей (Model Registry): Централизованный реестр обученных моделей, где хранятся их артефакты, параметры обучения и метрики качества.

Версионирование позволяет воспроизводить эксперименты, сохраняя состояние данных, моделей и кода в конкретный момент времени.

Сотрудничество (Collaboration)

MLOps — это в первую очередь культурный сдвиг, направленный на разрушение «стен» между Data Science, Data Engineering и DevOps/Ops. Он способствует созданию единых кросс-функциональных команд, которые говорят на одном языке и используют общие метрики, привязанные к бизнес-целям, а не только к техническим показателям (вроде F1-score).

Следовательно, архитектура системы должна учитывать изменчивость данных. Данные могут менять распределение со временем, что приводит к устареванию модели. Этот феномен называется дрейфом данных (Data Drift). MLOps предлагает инструменты для автоматического отслеживания таких изменений. Кроме того, архитектура включает конвейеры (pipelines) для автоматической обработки данных.

Важно отметить разницу в тестировании. В классическом DevOps мы тестируем функциональность кода (unit-тесты). В MLOps мы дополнительно тестируем качество данных и метрики точности модели. Это требует создания специализированных тестов валидации данных.

Принцип работы и жизненный цикл MLOps (The MLOps Lifecycle)

Механизм работы MLOps строится вокруг автоматизированного конвейера, который связывает все этапы разработки. Этот процесс цикличен и не заканчивается после развертывания модели. Полный MLOps-цикл представляет собой замкнутую петлю, где каждый этап автоматизирован и связан с другими.

Сбор и инжиниринг данных (Data Engineering)

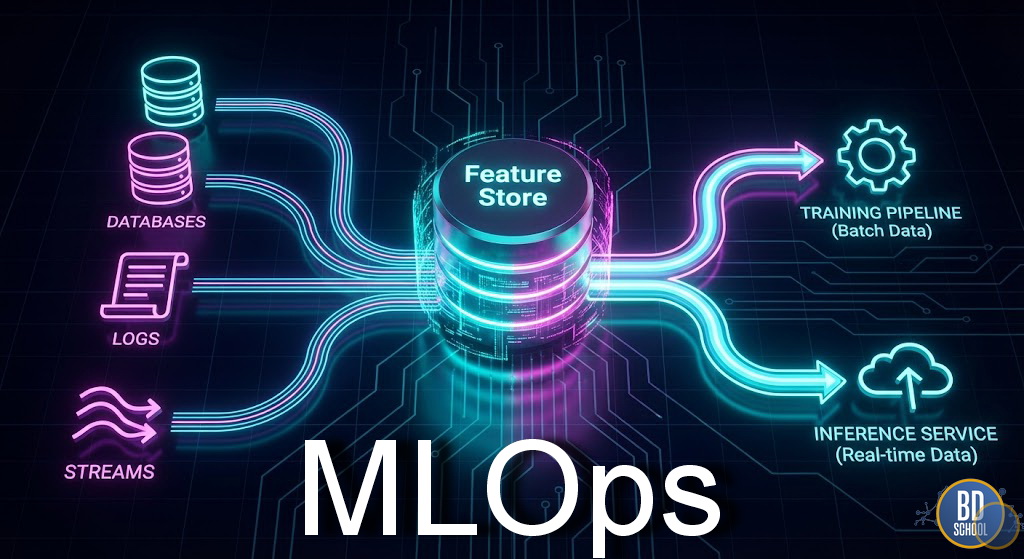

Все начинается с данных. Этот этап включает настройку ETL/ELT-процессов для сбора данных из различных источников (БД, стриминг, DWH). Ключевой MLOps-практикой здесь является валидация данных — автоматическая проверка качества, поиск аномалий и соответствие схеме (с помощью инструментов типа Great Expectations).

Здесь же происходит инжиниринг фичей (Feature Engineering). Лучшей практикой считается использование Feature Store (Хранилище фичей) — централизованного сервиса, который хранит, версионирует и подает фичи как для обучения (offline), так и для инференса (online). Это решает критическую проблему расхождения online/offline логики.

Разработка и обучение модели (Model Training)

Этот этап превращается из «ручного» R&D в автоматизированный пайплайн. Ключевым элементом здесь является трекинг экспериментов (Experiment Tracking). С помощью инструментов (например, MLflow) автоматически записываются все параметры, метрики, зависимости и артефакты каждого «прогона» модели. Это обеспечивает полную воспроизводимость. Пайплайн обучения (training pipeline) пишется как код и версионируется. Успешная модель сохраняется в Реестр моделей (Model Registry).

Валидация и тестирование (Model Validation)

Перед развертыванием модель проходит многоуровневое тестирование. Помимо юнит-тестов кода, MLOps-пайплайн включает:

- Тестирование данных (проверка на адекватность).

- Тестирование модели: оценка метрик (accuracy, RMSE и т.д.) на отложенной выборке, тестирование на устойчивость (robustness), проверка на предвзятость (fairness, bias).

- Сравнение с предыдущей (уже работающей в production) версией модели. Новая модель выкатывается, только если она «лучше» старой по заданным критериям.

Развертывание (Model Deployment)

Модель упаковывается (например, в Docker-контейнер) и развертывается. Существуют разные стратегии:

- Offline / Batch Prediction: Модель запускается по расписанию (например, раз в день) и сохраняет прогнозы в БД.

- Online / Real-time Serving: Модель развернута как API (REST/gRPC) и дает прогнозы по запросу.

Для снижения рисков используются продвинутые паттерны выкатки:

- Shadow Deployment (Теневое развертывание): Новая модель получает копию production-трафика, ее ответы записываются, но не отдаются пользователю. Это позволяет «вживую» протестировать модель, не влияя на пользователей.

- Canary Deployment (Канареечное развертывание): Новая модель получает малый процент (5-10%) реального трафика. Если она показывает себя хорошо, трафик постепенно увеличивается.

- A/B Testing: Две модели (старая и новая) работают параллельно на разных сегментах аудитории, что позволяет сравнить их бизнес-эффективность.

Мониторинг и эксплуатация (Model Monitoring)

После развертывания начинается самый важный этап. Система мониторинга отслеживает:

- IT-инфраструктуру: Нагрузка (CPU/GPU), задержка ответа (latency), количество ошибок.

- Мониторинг данных: Отслеживание дрейфа входных данных (статистические тесты).

- Мониторинг качества модели: Отслеживание падения метрик. Это самая сложная часть, так как требует наличия «ground truth» (реальных ответов), которые могут поступать с задержкой (Feedback Loop).

При срабатывании алертов (например, «точность упала на 10%») система может автоматически запустить следующий этап.

Переобучение (Retraining)

Цикл замыкается. При получении сигнала от системы мониторинга или по расписанию (например, «каждый понедельник на новых данных за неделю») автоматически запускается пайплайн переобучения (CT). Новая модель проходит все этапы (обучение, валидация, тестирование) и, если она оказывается лучше текущей, автоматически развертывается, заменяя ее.

Каждый этап этого процесса должен быть воспроизводимым. Это означает, что любой член команды может повторить результат, используя те же данные и код. Для этого используются инструменты трекинга экспериментов. Они записывают параметры запуска, версии библиотек и полученные метрики. Таким образом, MLOps превращает ручную работу Data Scientist-а в предсказуемый инженерный процесс. Это снижает риск человеческой ошибки при переносе модели в продакшн.

Уровни зрелости MLOps

Внедрение методологии происходит поэтапно, и Google выделяет три основных уровня зрелости процессов MLOps. Понимание текущего уровня помогает компании планировать дальнейшее развитие инфраструктуры. Компании обычно проходят несколько этапов на пути к полному MLOps (согласно модели, популяризированной Google):

- Уровень 0: Ручной процесс. Все делается вручную. Data Science и Ops — раздельные команды. Модели передаются «через стену» как артефакты.

- Уровень 1: Автоматизация ML-пайплайна. Процесс обучения и валидации модели автоматизирован (есть пайплайн). Это позволяет быстро переобучать модель. Однако развертывание и управление все еще ручные.

- Уровень 2: CI/CD для пайплайнов. Высший уровень зрелости. Внедрена полная CI/CD-система, которая автоматически тестирует и развертывает не только модели, но и сами ML-пайплайны. Внедрен автоматический мониторинг и триггеры для переобучения.

Переход между уровнями требует инвестиций в инструменты и обучение команды. Однако, достижение второго уровня позволяет выпускать новые версии моделей ежедневно.

Сценарии использования MLOps

Применение MLOps критически важно в отраслях, где данные быстро меняются или цена ошибки высока. Без автоматизации модели быстро теряют актуальность и приносят убытки.

Типовые сценарии внедрения включают:

-

Финансовый сектор (Скоринговые модели): Банки используют MLOps для ежедневного обновления моделей кредитного скоринга. Поведение клиентов меняется, и модель должна адаптироваться к новым экономическим условиям.

-

Ритейл (Рекомендательные системы): Магазины обновляют рекомендации товаров в реальном времени. Автоматизация позволяет учитывать недавние просмотры пользователя мгновенно.

-

Промышленность (Предиктивное обслуживание): Датчики оборудования генерируют потоки данных. Система автоматически выявляет аномалии и предупреждает о поломках, постоянно дообучаясь на новых паттернах.

-

Медицина (Диагностика): Модели анализа снимков требуют строгого контроля версий и воспроизводимости. Реестр моделей гарантирует, что используется именно проверенная версия алгоритма.

Во всех этих случаях ручное обновление моделей было бы слишком медленным. MLOps обеспечивает необходимую скорость и надежность.

Инструменты для управление MLOps и технологический стек (с акцентом на российский рынок)

Для реализации практик MLOps используется специализированный стек технологий. Одним из самых популярных инструментов является MLflow для трекинга экспериментов и DVC для версионирования данных.

Ниже приведен пример настройки трекинга экспериментов с использованием Python и MLflow. Этот код демонстрирует, как логировать параметры и метрики модели (Python-код для трекинга эксперимента):

import mlflow

import mlflow.sklearn

from sklearn.ensemble import RandomForestRegressor

from sklearn.metrics import mean_squared_error

# Установка URI для сервера трекинга

mlflow.set_tracking_uri("http://localhost:5000")

# Название эксперимента MLOps

mlflow.set_experiment("mlops_wiki_experiment")

def train_model(params, X_train, y_train, X_test, y_test):

with mlflow.start_run():

# Логирование гиперпараметров

mlflow.log_params(params)

# Инициализация и обучение модели

rf = RandomForestRegressor(**params)

rf.fit(X_train, y_train)

# Предсказание и расчет метрики

predictions = rf.predict(X_test)

mse = mean_squared_error(y_test, predictions)

# Логирование метрики качества

mlflow.log_metric("mse", mse)

# Сохранение самой модели в реестр MLOps

mlflow.sklearn.log_model(rf, "random_forest_model")

print(f"Model saved with MSE: {mse}")

# Пример запуска функции (данные должны быть предварительно загружены)

# train_model({"n_estimators": 100, "max_depth": 5}, X_train, y_train, X_test, y_test)

Кроме кода обучения, важной частью является управление данными. Для этого часто используется DVC (Data Version Control). Он работает поверх Git. Команды CLI для версионирования данных (DVC):

# Инициализация DVC в проекте MLOps dvc init # Добавление файла данных под контроль версий dvc add data/dataset.csv # DVC создает файл dataset.csv.dvc, который нужно закоммитить в Git git add data/dataset.csv.dvc .gitignore git commit -m "Add dataset for MLOps pipeline" # Отправка данных в удаленное хранилище (например, S3) dvc push

Эти инструменты позволяют связать конкретную версию кода с конкретной версией данных. Это фундамент воспроизводимости в MLOps. На российском рынке MLOps-стек чаще всего строится на базе Open Source или с использованием платформ отечественных облачных провайдеров.

Open Source (Основа для on-premise)

Это «конструктор», из которого компании строят собственные MLOps-платформы.

- Оркестрация: Kubeflow, Airflow, Argo Workflows.

- Версионирование: Git (для кода), DVC (для данных), MLflow (для экспериментов и моделей).

- Feature Stores: Feast.

- Сервинг: Seldon Core, KServe, BentoML.

- Мониторинг: Prometheus + Grafana (для IT-метрик), Evidently AI, NannyML (для дрейфа данных).

Российские облачные платформы (ML PaaS)

Провайдеры предлагают комплексные управляемые MLOps-платформы, снимая с команд инфраструктурные заботы.

- Yandex Cloud: Платформа Yandex DataSphere предлагает комплексную среду для ML-разработки (Jupyter, трекинг, serverless-запуск) с тесной интеграцией с другими сервисами (Kubernetes, S3, Managed Databases).

- VK Cloud: Предлагает «Платформу для Data-разработки» и сервисы для Big Data, Kubernetes и GPU.

- Selectel: Предоставляет управляемую ML-платформу (часто на базе Kubeflow) и мощную инфраструктуру (выделенные серверы с GPU, S3).

- SberCloud (GigaChat): Развивает платформу ML Space для корпоративных клиентов, с фокусом на Generative AI (LLMOps).

Роли и организационная структура

Внедрение MLOps меняет и структуру команд:

- Data Scientist: Фокусируется на исследованиях, поиске инсайтов и создании прототипов моделей.

- ML Engineer (ML-инженер): Это ключевая роль в MLOps. «Гибридный» специалист, который забирает прототип у Data Scientist и превращает его в production-ready пайплайн. Он отвечает за код, тестирование, развертывание и мониторинг. Это относительно новая и востребованная специальность, требующая знаний на стыке Data Science и DevOps.

- Data Engineer: Отвечает за доступность и качество данных, строит ETL/ELT-пайплайны, управляет Feature Store.

- DevOps Engineer: Отвечает за базовую инфраструктуру (Kubernetes, сети, CI/CD-инструменты).

- Product Manager: Определяет бизнес-ценность ML-решения и его KPI.

Вызовы и будущие направления

MLOps является необходимым стандартом для современной разработки систем искусственного интеллекта. Он решает критические проблемы масштабируемости, надежности и скорости обновлений ML-продуктов. Переход от ручных запусков к автоматизированным конвейерам позволяет бизнесу быстрее получать ценность от данных. В конечном счете, успешное внедрение MLOps определяет конкурентное преимущество компании на рынке высоких технологий.

Несмотря на очевидные преимущества, внедрение MLOps сопряжено с вызовами. Главные из них — высокая сложность технологического стека, организационное сопротивление (необходимость культурного сдвига) и острая нехватка ML-инженеров.

Рынок активно реагирует на этот кадровый голод появлением специализированных образовательных программ. Например, курс по MLOps от BigDataSchool целенаправленно готовит инженеров, способных с нуля спроектировать и внедрить полный MLOps-цикл в компании.

В то же время сама дисциплина MLOps продолжает развиваться. Новым горячим направлением стал LLMOps / GenOps — практики MLOps, адаптированные для управления большими языковыми моделями (Generative AI). Здесь фокус смещается на управление промптами, RAG-системами (Retrieval-Augmented Generation) и процессами тонкой настройки (fine-tuning) гигантских моделей.

Референсные ссылки

-

Руководство Google по уровням MLOps. Continuous delivery and automation pipelines in machine learning https://cloud.google.com/architecture/mlops-continuous-delivery-and-automation-pipelines-in-machine-learning

-

Документация MLflow. Платформа с открытым исходным кодом для жизненного цикла машинного обучения https://mlflow.org/docs/latest/index.html

-

Введение в DVC. Data Version Control для MLOps https://dvc.org/doc

-

Манифест MLOps. Принципы инженерии машинного обучения https://ml-ops.org/

512

512