Содержание

- Ключевые компоненты архитектуры Autonomous Prompting

- Цель (The Goal)

- Планировщик (Planner)

- Исполнитель (Executor)

- Память и Контекст (Memory)

- Принцип работы: Цикл Autonomous Prompting

- Этап 1: Постановка цели и первый промпт

- Этап 2: Выполнение и Рефлексия (Самокритика)

- Этап 3: Итерация и генерация следующего промпта

- Связь с фреймворком ReAct (Reason + Act)

- Сценарии использования Autonomous Prompting

- Взаимодействие: Пример реализации AI-агента (Python)

- Практический пример: Создание ReAct агента (LangChain)

- Autonomous Prompting против Chain-of-Thought (CoT)

- Вызовы и риски: Управление автономными агентами

- Заключение

- Референсные ссылки

Autonomous Prompting (Автономный Промптинг) — это продвинутая методология взаимодействия с ИИ, при которой система (или «агент») способна самостоятельно генерировать, выполнять и итерировать последовательность запросов (промптов) для достижения сложной, высокоуровневой цели, поставленной человеком. Вместо того чтобы пассивно ждать от пользователя следующей точной команды, модель ИИ сама инициирует запросы, разбивает задачи на подзадачи и формирует промежуточные инструкции для самой себя.

Этот подход является логическим продолжением таких техник, как Chain-of-Thought (CoT). Он позволяет модели «рассуждать вслух» и корректировать свои действия без постоянного микроменеджмента со стороны человека. По сути, Autonomous Prompting (далее AP) превращает LLM из «инструмента» в «исполнителя». Вы больше не даете точные инструкции (как плотнику), а ставите цель (как менеджеру проекта).

Взаимодействие с ИИ становится похожим на диалог коллеги с коллегой: система не ждет уточнений от «начальника», а помогает двигаться к результату самостоятельными, проактивными шагами.

Ключевые компоненты архитектуры Autonomous Prompting

Для создания автономного ИИ-агента недостаточно одной LLM. Требуется архитектура, в которой Autonomous Prompting является рабочим механизмом. Эта архитектура обычно состоит из четырех ключевых компонентов.

Цель (The Goal)

Это высокоуровневая, часто общей формулировки, задача, которую ставит человек. Например: «Проанализируй отчеты о продажах за Q3, найди главные инсайты и подготовь презентацию». В традиционном подходе для этого потребовалось бы 100 отдельных промптов. В Autonomous Prompting — это всего лишь стартовая точка.

Планировщик (Planner)

Это «мозг» операции, обычно реализованный на базе мощной LLM (как GPT-4 или Claude 3). Получив Цель, Планировщик декомпозирует ее на логическую последовательность шагов. Он генерирует первый автономный промпт для самого себя: «Окей, чтобы сделать презентацию, мне сначала нужно найти отчеты. Шаг 1: Найти файлы ‘sales_report_q3.pdf'».

Исполнитель (Executor)

Это «руки» системы. Исполнитель берет конкретный шаг от Планировщика и выполняет его. Важно, что Исполнитель — это не обязательно та же самая LLM. Это может быть:

- Другая LLM: Более простая и дешевая модель, заточенная под конкретную задачу (например, суммаризация текста).

- Инструменты (Tools): API для поиска в интернете, интерпретатор Python для выполнения кода, API к базе данных для SQL-запросов или доступ к файловой системе.

Память и Контекст (Memory)

Это «рабочая тетрадь» агента. После каждого шага результат (успех, неудача, полученные данные) записывается в Память. Когда Планировщик генерирует следующий промпт, он учитывает не только общую Цель, но и всю историю в Памяти («Я уже искал отчеты, нашел три файла, теперь их нужно прочитать»). Это позволяет системе не терять контекст и учиться на своих ошибках в рамках одной сессии.

Принцип работы: Цикл Autonomous Prompting

Autonomous Prompting работает не как линейный процесс, а как непрерывный цикл. Этот цикл часто называют «Plan-Act-Observe-Reflect» (Планируй-Действуй-Наблюдай-Рефлексируй).

ИИ-агенты для оптимизации бизнес-процессов

Код курса

AGENT

Ближайшая дата курса

18 мая, 2026

Продолжительность

24 ак.часов

Стоимость обучения

66 000

Этап 1: Постановка цели и первый промпт

Пользователь дает Цель (например, «Сравни LLM и Data Vault»). Планировщик берет эту цель и генерирует первый внутренний промпт (план):

Шаг 1: Найти определение LLM.

Шаг 2: Найти определение Data Vault.

Шаг 3: Сравнить их.

Этап 2: Выполнение и Рефлексия (Самокритика)

Система берет «Шаг 1: Найти определение LLM» и передает его Исполнителю (например, инструменту «Веб-Поиск»). Исполнитель возвращает результат («LLM — это большая языковая модель…»). Этот результат записывается в Память.

Затем наступает ключевой этап — Рефлексия. Планировщик «смотрит» на результат и сам себя спрашивает (новый автономный промпт): «Задача выполнена? Да. Что дальше по плану? Шаг 2. Запускаем Шаг 2». Если бы поиск провалился, промпт Рефлексии был бы другим: «Задача провалена. Почему? Вероятно, был плохой поисковый запрос. Попробуем переформулировать: ‘Что такое Large Language Model'».

Этап 3: Итерация и генерация следующего промпта

Этот цикл (План -> Действие -> Результат -> Рефлексия) повторяется снова и снова. Каждый «оборот» этого цикла — это, по сути, новый Autonomous Prompt, который система генерирует для самой себя, уточняя, что делать дальше. Процесс завершается, когда Планировщик решает, что первоначальная Цель полностью достигнута.

Связь с фреймворком ReAct (Reason + Act)

Этот цикл был во многом формализован в подходе ReAct (Reason + Act). Это одна из первых и самых успешных реализаций Autonomous Prompting. LLM учится генерировать вывод в строго определенном формате, который содержит:

- Thought (Мысль): Рассуждение о том, что нужно сделать дальше (это и есть автономный промпт).

- Action (Действие): Выбор конкретного Инструмента и запроса к нему (например, SearchTool(‘определение Data Vault’)).

- Observation (Наблюдение): Результат, который вернул инструмент.

Увидев Наблюдение, LLM снова генерирует Мысль, и цикл повторяется до достижения финального ответа.

Сценарии использования Autonomous Prompting

Ценность этого подхода в том, что он позволяет автоматизировать сложные, многоэтапные процессы, которые раньше требовали постоянного контроля человека. В бизнесе уже применяются агенты, способные выполнять такие задачи:

- Юридическая экспертиза: Агент получает Цель «Проверь этот договор на риски». Он самостоятельно находит нужные статьи закона (через поиск), сравнивает их с пунктами договора (анализ текста) и готовит итоговый отчет.

- Обработка медицинских документов: Агент получает скан истории болезни и Цель «Собери анамнез». Он распознает текст, извлекает ключевые диагнозы, даты и назначения, структурирует их и заносит в базу данных.

- Клиентская поддержка: Вместо простого чат-бота, агент Autonomous Prompting может получить жалобу клиента, самостоятельно проверить статус заказа в CRM, проверить статус платежа в биллинге и, если нужно, оформить возврат, выполнив 4-5 разных действий.

- Планирование проектов: Агент, получив Цель «Спланировать запуск продукта X», может сам исследовать рынок, составить список задач, распределить их по спринтам и даже создать тикеты в Jira.

Исследования MIT показывают, что такие техники самокоррекции (self-prompting) помогают сократить разрыв в качестве результата между новичками и опытными пользователями. Даже без идеального промпта система сама «додумывает» нужные шаги.

Взаимодействие: Пример реализации AI-агента (Python)

Проще всего реализовать Autonomous Prompting с помощью фреймворков вроде LangChain или LlamaIndex. Они предоставляют готовые компоненты (Планировщики, Инструменты, Память).

Рассмотрим пример простого «агента-исследователя» на LangChain, который использует ReAct.

Практический пример: Создание ReAct агента (LangChain)

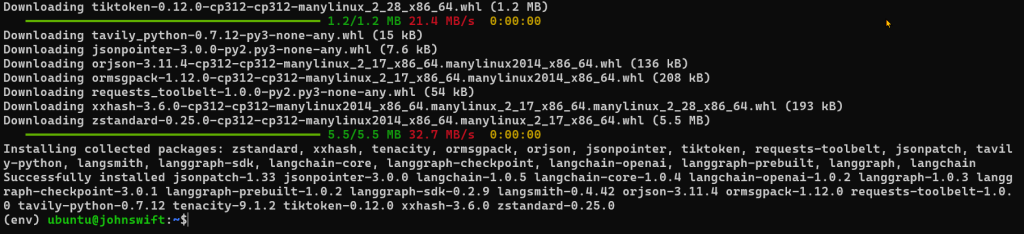

Нам понадобятся библиотеки langchain, openai (для LLM) и tavily-python (для поискового инструмента).

# Установка необходимых библиотек pip install langchain langchain-openai tavily-python langchain-community

Теперь создадим самого агента. ( Примечание: придется поэкспериментировать с версиями langchain)

import os

from langchain_openai import ChatOpenAI

from langchain_community.tools.tavily_search import TavilySearchResults

from langchain_community.utilities.tavily_search import TavilySearchAPIWrapper

from langchain.agents import initialize_agent, AgentType

# 1. Ключи

os.environ["OPENAI_API_KEY"] = "sk-..."

os.environ["TAVILY_API_KEY"] = "tvly-..."

# 2. Модель

llm = ChatOpenAI(model="gpt-4-turbo")

# 3. Инструмент Tavily

tavily = TavilySearchAPIWrapper()

tools = [TavilySearchResults(api_wrapper=tavily, max_results=3)]

# 4. Создаём агента (тип: ZERO_SHOT_REACT_DESCRIPTION)

agent = initialize_agent(

tools=tools,

llm=llm,

agent=AgentType.ZERO_SHOT_REACT_DESCRIPTION,

verbose=True

)

# 5. Запрос

result = agent.invoke("Кто такой Дэн Линстедт и что такое Data Vault?")

print("\n--- Итоговый ответ ---")

print(result)

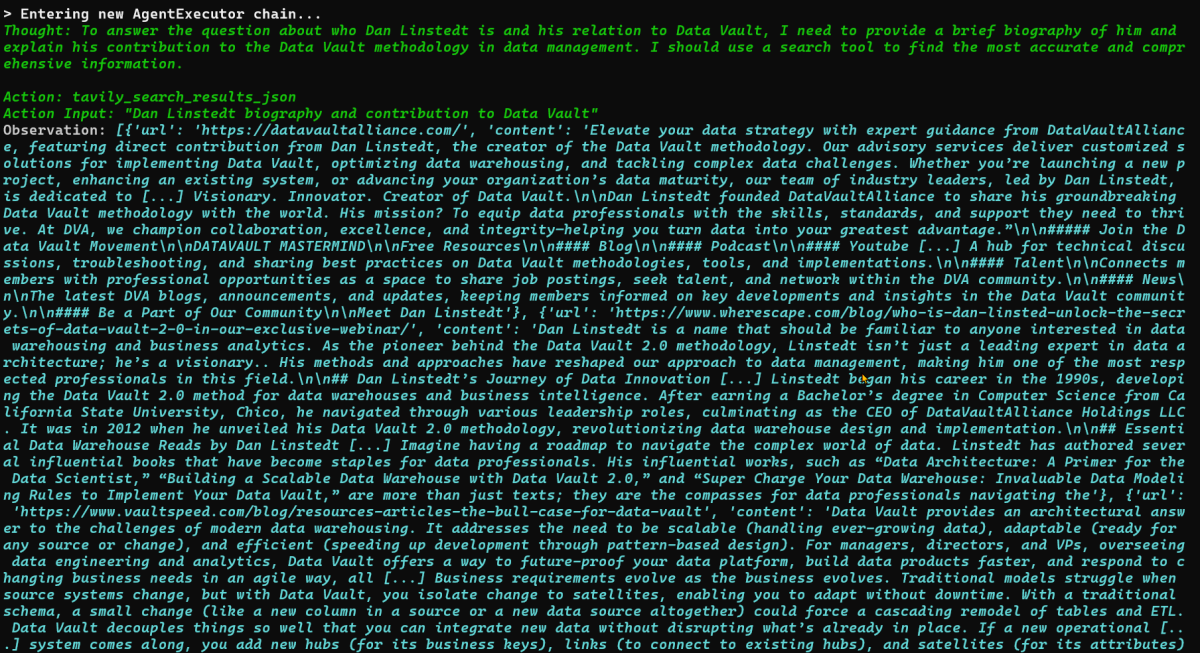

Если вы запустите этот код (с verbose=True), вы увидите в консоли тот самый Autonomous Prompting в действии. Вывод будет примерно таким:

> Entering new AgentExecutor chain…

Thought (Мысль): Мне нужно узнать, кто такой Дэн Линстедт и его связь с Data Vault. Я начну с поиска «Дэн Линстедт Data Vault».

Action (Действие): tavily_search(query=»Дэн Линстедт Data Vault»)

Observation (Наблюдение): [Результат поиска: «Дэн Линстедт (Dan Linstedt) является создателем методологии Data Vault, гибридного подхода к…»]

Thought (Мысль): Я нашел ответ. Дэн Линстедт — создатель Data Vault. Я могу сформулировать итоговый ответ.

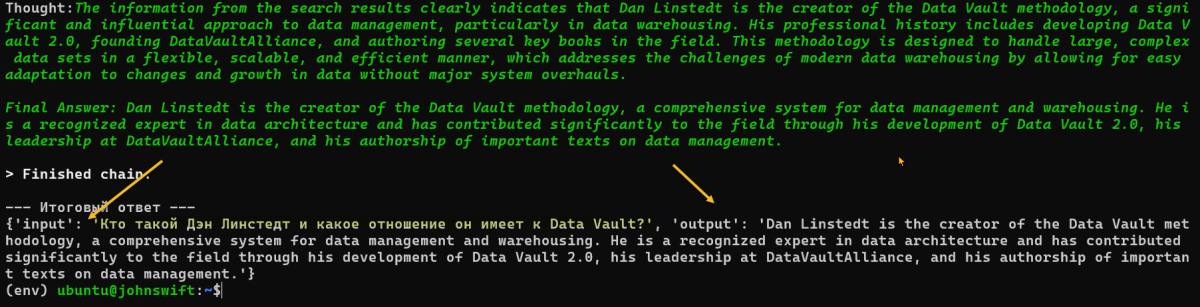

Action (Действие): Final Answer(Ответ): Дэн Линстедт — это создатель (часто называемый ‘отцом’) методологии хранилищ данных Data Vault. Он разработал этот подход в 1990-х годах…

Finished chain.

— Итоговый ответ —

Дэн Линстедт — это создатель (часто называемый ‘отцом’) методологии хранилищ данных Data Vault. Он разработал этот подход в 1990-х годах…

Каждый блок Thought — это автономный промпт, который LLM сгенерировала для самой себя.

ИИ-агенты для оптимизации бизнес-процессов

Код курса

AGENT

Ближайшая дата курса

18 мая, 2026

Продолжительность

24 ак.часов

Стоимость обучения

66 000

Autonomous Prompting против Chain-of-Thought (CoT)

Важно не путать Autonomous Prompting с другими техниками.

- Basic Prompting: Вы даете один запрос, получаете один ответ. (Запрос -> Ответ).

- Chain-of-Thought (CoT): Вы просите модель «рассуждать по шагам» внутри одного ответа. Модель генерирует рассуждение и ответ за один проход. Это улучшает точность, но это все еще один запрос. (Запрос -> Рассуждение + Ответ).

- Autonomous Prompting: Вы даете цель. Модель выполняет множество циклов «Рассуждение -> Действие -> Наблюдение». Она реально взаимодействует с инструментами и генерирует десятки новых промптов для себя, прежде чем дать финальный ответ.

Вызовы и риски: Управление автономными агентами

Autonomous Prompting — это невероятно мощный инструмент, но он несет и риски:

Стоимость: Агент, который для ответа на вопрос решил «прочитать весь интернет», может выполнить тысячи поисковых запросов и сжечь ваш API-бюджет за минуты.

«Галлюцинации» в Планировании: Планировщик может зациклиться, «забыть» первоначальную цель или составить неверный план, что приведет к неверному результату.

Безопасность: Предоставление ИИ-агенту доступа к «Исполнителям» (инструментам), таким как терминал (bash) или файловая система, требует высочайшей осторожности.

Заключение

Autonomous Prompting — это фундаментальный сдвиг в том, как мы взаимодействуем с ИИ. Он экономит ресурсы, так как вместо десятков точных инструкций от человека, ИИ достаточно задать общее направление.

Это превращает Промпт-инжиниринг из технического навыка «как правильно составить запрос» в стратегический навык «как правильно поставить цель». Autonomous Prompting делает ИИ-системы более устойчивыми благодаря внутренней проверке собственных шагов и самокоррекции. Цифровые ассистенты становятся настоящими организаторами, самостоятельно двигающими процесс вперед, вместо того чтобы ждать указаний.

Референсные ссылки

- LangChain Agents Documentation (Официальная документация LangChain по Агентам) (https://python.langchain.com/docs/modules/agents/)

- ReAct: Synergizing Reasoning and Acting in Language Models (arXiv.org) (https://arxiv.org/abs/2210.03629)

- What Is an AI Agent? (NVIDIA Blogs) (https://blogs.nvidia.com/blog/what-is-an-ai-agent/)

- The Rise of Autonomous AI Agents (Turing.com) (https://www.turing.com/blog/autonomous-ai-agents-everything-you-need-to-know)

534

534