Мы уже упоминали формат Parquet в статье про Apache Avro, одну из наиболее распространенных схем данных Big Data, часто используемую в Kafka, Spark и Hadoop. Сегодня рассмотрим более подробно, чем именно хорошо Apache Parquet и как он отличается от других форматов Big Data. Что такое Apache Parquet и как он...

Для высоконагруженных Big Data систем и платформ интернета вещей (Internet of Things, IoT) с непрерывными информационными потоками Apache Kafka, практически, стала стандартом де факто для обмена сообщениями и управления очередями. Аналогичную популярность среди DevOps-инструментов завоевал Kubernetes (K8s) как наиболее мощное средство для автоматизации развертывания и управления контейнеризованными приложениями. В этой...

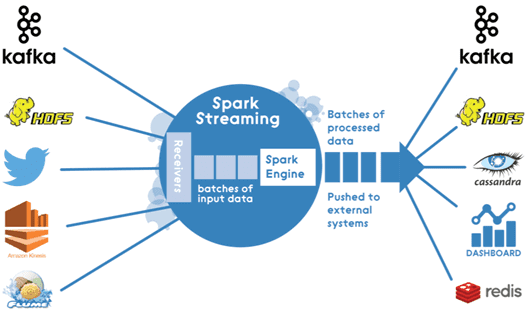

Мы уже рассказывали, зачем нужна интеграция Apache Kafka и Spark Streaming. Сегодня рассмотрим, как технически организовать такой Big Data конвейер по непрерывной обработке потоковых данных в режиме реального времени. Способы интеграции Наладить двустороннюю связь между Apache Kafka и Spark Streaming возможны следующими 2-мя способами: получение сообщений через службу синхронизации Zookeeper...

В этой статье мы рассмотрим архитектуру Big Data конвейера по непрерывной обработке потоковых данных в режиме реального времени на примере интеграции Apache Kafka и Spark Streaming. Что такое Spark Streaming и для чего он нужен Spark Streaming – это надстройка фреймворка с открытым исходным кодом Apache Spark для обработки потоковых...

Apache Kafka – не единственный программный брокер сообщений и система управления очередями, используемая в высоконагруженных Big Data проектах. Кафка часто сравнивают с другим популярным продуктом аналогичного назначения – RabbitMQ. В сегодняшней статье мы рассмотрим, чем похожи и чем отличаются Apache Kafka и RabbitMQ, а также поговорим о том, что следует...

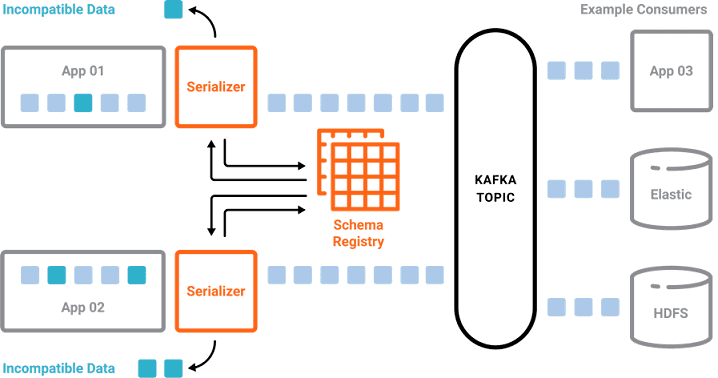

Мы уже рассказывали о сериализации, схемах данных и их важности в Big Data на примере Schema Registry для Apache Kafka. В продолжение ряда статей про основы Кафка для начинающих, сегодня мы поговорим про Apache Avro – наиболее популярную схему и систему сериализации данных: ее особенностях и применении в технологиях Big...

Продолжая серию публикаций про основы Apache Kafka для начинающих, в этой статье мы рассмотрим, зачем этой распределенной системе управления сообщениями нужен реестр схем данных (Schema Registry) и что такое сериализация файлов Big Data. Что такое схемы данных в Big Data и как они используются Понятие схемы неразрывно связано с форматом...

В рамках серии публикаций про основы Apache Kafka для начинающих, сегодня мы поговорим про информационную безопасность этой популярной в сфере Big Data распределенной системы управления сообщениями: шифрование, защищенные протоколы, аутентификация, авторизация и другие средства cybersecurity. Что обеспечивает безопасность Apache Kafka в кластере Big Data Информационная безопасность Apache Kafka основана на...

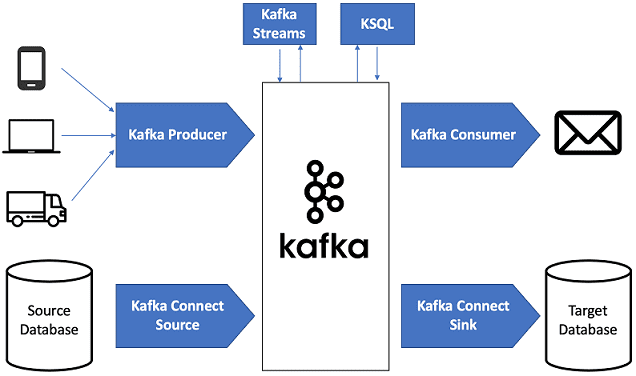

Продолжая разговор про основы Apache Kafka, сегодня мы рассмотрим, почему этот распределённый брокер сообщений стал таким популярным в архитектуре систем Big Data. Читайте в нашей статье, как Кафка обеспечивает высокую производительность процессов сбора и агрегации информационных потоков от множества источников, надежно гарантируя долговечную сохранность сообщений, и эффективно интегрируется с другими...

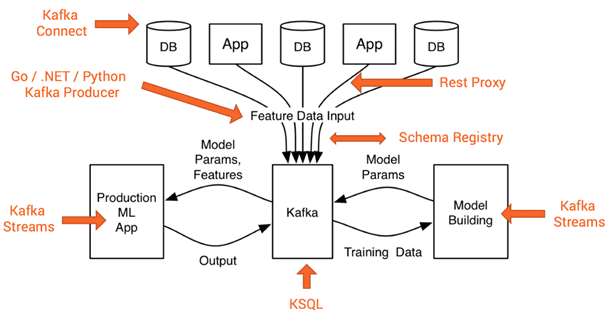

Рассмотрев основы Apache Kafka, сегодня мы расскажем о месте этого распределённого брокера сообщений в архитектуре Big Data систем. Читайте в нашей статье, какие компоненты Кафка обеспечивают ее использование в программных продуктах машинного обучения (Machine Learning, ML), интернете вещей (Internet Of Things, IoT), системах бизнес-аналитики (Business Intelligence, BI), а также других...

Мы уже упоминали Apache Kafka в статье про промышленный интернет вещей (Industrial Internet Of Things, IIoT). Сегодня поговорим о том, где и для чего еще в Big Data проектах используется эта распределённая, горизонтально масштабируемая система обработки сообщений. Как работает Apache Kafka Apache Kafka позволяет в режиме онлайн обеспечить сбор и...

Мы уже рассказывали про достоинства и недостатки самой популярной DevOps-технологии 2019 года – платформы управления контейнерами Kubernetes для Big Data систем. Сегодня поговорим, зачем вообще нужны контейнеры, чем они отличаются от виртуальных машин, каковы их плюсы и минусы, а также для чего нужна их оркестрация. Что такое контейнеризация приложений и...

Сегодня, когда ИТ-компании распиливают монолиты своих Big Data систем на микросервисы, а DevOps-подход совершает свое победное шествие по локальным и облачным кластерам, Kubernetes стал, пожалуй, самой востребованной технологией 2019 года. Однако, K8s нужен далеко не каждому проекту. В этой статье мы поговорим о достоинствах и недостатках кубернетис, в каких случаях...

В прошлых выпусках мы рассмотрели, чем занимаются аналитик (Data Analyst), исследователь (Data Scientist) и инженер больших данных (Data Engineer). Завершая цикл статей о самых популярных профессиях Big Data, поговорим об администраторе больших данных – его рабочих обязанностях, профессиональных компетенциях, зарплате и отличиях от других специалистов. Итак, в сегодняшней статье –...

Мы уже рассказывали о некоторых профессиях Big Data, например, объясняли «для чайников», кто такие аналитик (Data Analyst) и исследователь (Data Scientist): что каждый из них должен знать и уметь, чем они занимаются и как отличаются друг от друга. Сегодня поговорим об инженере данных (Data Engineer) – его рабочих обязанностях, профессиональных...

В этом выпуске мы продолжаем введение в Data Science для чайников, разбирая профессии Big Data, и рассказываем, кто такой Data Scientist: что необходимо знать ученому по данным и чем исследователь отличается от аналитика. Что делает ученый по данным Как и Data Analyst, исследователь данных тоже работает с информационными массивами путем...

Продолжая разговор про то, с чего начать вход в большие данные, и какие бывают ИТ-специальности, сегодня мы расскажем, чем именно занимается аналитик Big Data, что он должен знать и уметь, а также где и как получить необходимые профессиональные компетенции. Что делает аналитик данных Как правило, Data Analyst работает с информационными...

Этой статьей мы продолжаем серию материалов по ИТ-специальностям мира больших данных и начинаем описывать профессиональные компетенции в области Big Data и машинного обучения (Machine Learning). Ищите в сегодняшнем выпуске ответ на главный вопрос новичка Big Data – с чего начать, что нужно знать и уметь, а также где этому учиться...

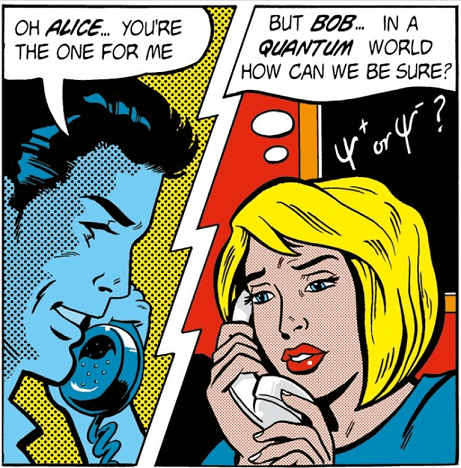

Почти каждая статья по системам шифрования и криптографическим методам иллюстрируется примере отношений Алисы с Бобом и прочими метафизическими личностями [1]. В продолжение темы информационной безопасности в интернете вещей и Big Data, сегодня мы поговорим о том, как именно криптография помогает защитить каналы передачи данных и IoT-устройства от перехвата управления и...

Продолжая разбираться с информационной безопасностью Internet of Things и Big Data систем, сегодня мы поговорим о каналах передачи данных – защищенных протоколах и криптографических средствах в smart-устройствах. От IoT-устройства в облако Big Data: особенности многоуровневой передачи данных по сетям Интернет вещей – это комплексная система трехзвенной архитектуры: информация с «умного»...