Если вы работаете с компьютерами и большими массивами информации, курсы по машинному обучению или повышению квалификации вам точно не помешают. Почему? Потому, что это направление стремительно становится популярным и востребованным. Искусственный интеллект из экспериментальной технологии как-то незаметно превратился в повседневный инструмент. Точнее, вот-вот таковым станет. Машинное обучение представляет собой комплекс...

Big Data – современное развитие науки о данных, появившейся примерно в середине шестидесятых годов прошлого века. Сейчас существует масса профессий, специалисты которых должны разбираться в Больших Данных. Кто-то должен быть экспертом в этой отрасли. Кому-то достаточно просто знать, что это такое. В любом случае, если вы работаете в информационной сфере...

Digital transformation или Цифровая трансформация – совокупность процессов по тотальному переходу от традиционных методов осуществления деятельности к максимально возможному внедрению современных Digital-технологий. Это новейший бизнес-тренд, направленный на компьютеризацию, использование общего и специального ПО, эксплуатация возможностей Интернета для повышения конкурентоспособности и роста прибыльности. Может показаться, что компьютеризация и использование различных программных...

Big Data или Большие Данные – совокупность технологий и инструментов, призванных решить проблему операций с большими информационными массивами. Причем значительно сокращаются проблемы не только с неструктурированными, но и структурированными данными. Проблема обработки крупных и часто хаотичных информационных пакетов зародилась в IT-сфере. С ростом компьютеризации общества и всех сфер его деятельности,...

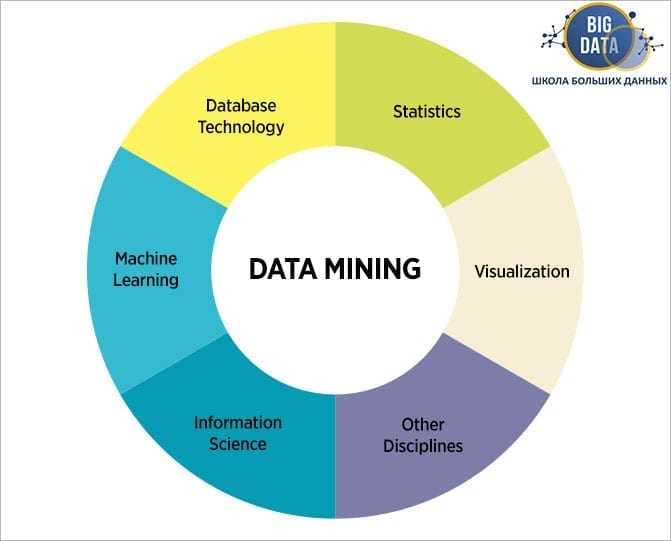

Одним из относительно новых терминов стало словосочетание Data mining, подразумевающее извлечение определенных данных из общего массива, упорядоченного или не упорядоченного. Работа с большими массивами данных – достаточно новая задача, инструментарий для решения которой в данный момент фактически только прорабатывается и совершенствуется. Подобных вызовов в практике человечества ранее не существовало, поэтому...

Планируем рабочие процессы вместе с Apache Airflow Почему Apache Airflow? Большинство процессов обработки данных строятся на определении набора «задач» для извлечения, анализа, преобразования, загрузки и хранения данных. Например, последовательность обработки данных может состоять из таких задач, как чтение логов из S3, создание задания Spark для извлечения соответствующих объектов, индексирование объектов...

Большие Данные (Big Data) – определение, широко используемое айтишниками, статистиками и другими специалистами, работающими с данными. В последнее время оно стало настолько распространенным, что просочилось из узкоспециализированной сферы в общий лексикон. Многие уже слышали разговоры о Big Data, но сходу не так просто разобраться, что это такое и где оно...

KSQL - это движок SQL с открытым исходным кодом для Apache Kafka. Он обеспечивает простой, но мощный интерактивный SQL интерфейс для потоковой обработки на Kafka, без необходимости писать код на языке программирования, таком как Java или Python. SELECT * FROM payments-kafka-stream WHERE fraud_probability > 0.8 ...

Знакомство с расширенными возможностями обеспечения безопасности озера данных под управлением Apache Ambari и Apache Ranger дистрибутива HortonWorks или Arenadata Hadoop. На протяжении 3 дней практического обучения вы рассмотрите вопросы установки и настройки эшелонированной защиты- безопасности озера данных (Data Lake security) Hadoop под управлением дистрибутива Hadoop компании HortonWorks с использованием протоколов...

Правительство Свердловской области на конкурсной основе выбрало совместные решения консорциума iDVP и компании «Корус АКС» для демонстрации развития проекта «Умный регион» в сфере «Образование». В рамках экспозиции «Корус АКС» на стенде Свердловской области будут представлены успешно реализованные проекты и прототипы в области продвинутой аналитики и 3D-визуализации больших данных: новая перспективная разработка для...

Послание Президента Республики Казахстан Н. Назарбаева народу Казахстана. 10 января 2018 г. (тезисы) Уважаемые казахстанцы! Сегодня мир вступает в эпоху Четвертой промышленной революции, эру глубоких и стремительных изменений: технологических, экономических и социальных. ... Принята комплексная программа «Цифровой Казахстан». ... Данное Послание определяет, что нам предстоит сделать для успешной навигации и адаптации в новом мире – мире Четвертой...